模型|经逆向工程,Transformer「翻译」成数学框架 | 25位学者撰文

机器之心报道

编辑:陈萍、杜伟

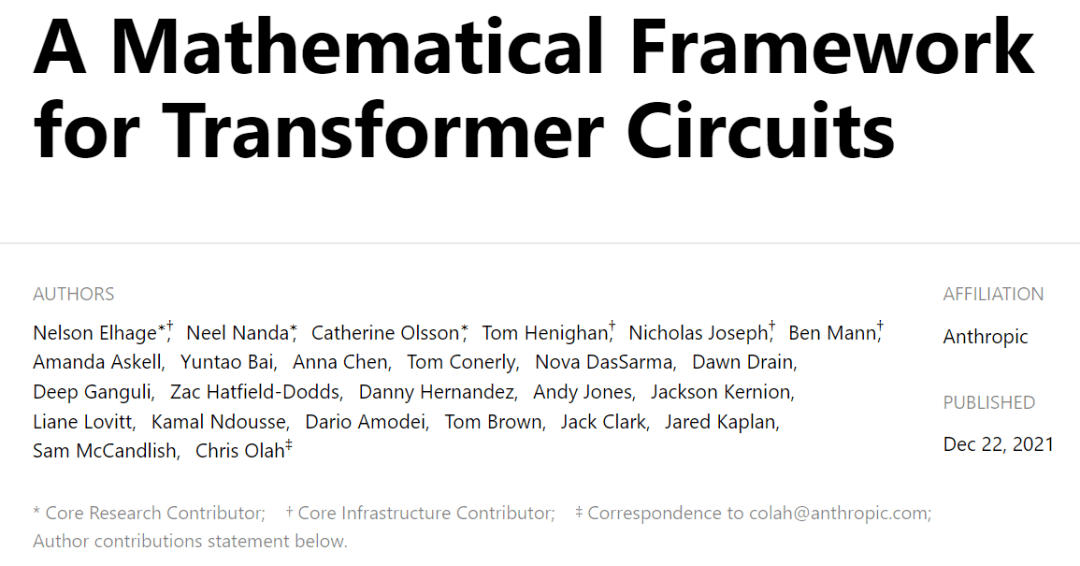

一篇多达 25 位研究者参与撰写的论文 , 以最简单的架构仅包含注意力块的两层或更少层的 transformer 模型为基础 , 对 Transformer 进行逆向研究 。Transformer 是 Google 团队在 2017 年 6 月提出的 NLP 经典之作 , 由 Ashish Vaswani 等人在论文《 Attention Is All You Need 》中提出 。 自 Transformer 出现以来 , 便在 NLP、CV、语音、生物、化学等领域引起了诸多进展 。

Transformer 在现实世界中的应用越来越广泛 , 例如 GPT-3 、LaMDA 、Codex 等都是基于 Transformer 架构构建的 。 然而 , 随着基于 Transformer 模型的扩展 , 其开放性和高容量为意想不到的甚至有害的行为创造了越来越大的空间 。 即使在大型模型训练完成数年后 , 创建者和用户也会经常发现以前从来没见过的模型问题 。

【模型|经逆向工程,Transformer「翻译」成数学框架 | 25位学者撰文】解决这些问题的一个途径是机械的可解释性(mechanistic interpretability) , 即对 transformers 计算过程进行逆向工程 , 这有点类似于程序员如何尝试将复杂的二进制文件逆向工程为人类可读的源代码 。

如果逆向工程可行 , 那么我们就会有更系统的方法来解释当前模型的安全问题、识别问题 , 甚至可能预见未来尚未构建的模型安全问题 。 这有点类似于将 Transformer 的黑箱操作进行逆向 , 让这一过程变得清晰可见 。 之前有研究者开发了 Distill Circuits thread 项目 , 曾尝试对视觉模型进行逆向工程 , 但到目前为止还没有可比的 transformer 或语言模型进行逆向工程研究 。

在本文中 , 由 25 位研究者参与撰写的论文 , 尝试采用最原始的步骤逆向 transformer 。 该论文由 Chris Olah 起草 , Chris Olah 任职于 Anthropic 人工智能安全和研究公司 , 主要从事逆向工程神经网络研究 。 之后 Neel Nanda 对论文初稿进行了重大修改 , Nanda 目前是 DeepMind 的一名研究工程实习生 。 Nelson Elhage 对论文进行了详细的编辑以提高论文章节清晰度 , Nelson Elhage 曾任职于 Stripe 科技公司 。

文章图片

左:Neel Nanda;右:Christopher Olah

考虑到语言模型的复杂性高和规模大等特点 , 该研究发现 , 从最简单的模型开始逆向 transformer 最有效果 。 该研究旨在发现简单算法模式、主题(motifs)或是框架 , 然后将其应用于更复杂、更大的模型 。 具体来说 , 他们的研究范围仅包括只有注意力块的两层或更少层的 transformer 模型 。 这与 GPT-3 这样的 transformer 模型形成鲜明的对比 , GPT-3 层数多达 96 层 。

推荐阅读

- 21世纪经济报道|地方政府跑步入局元宇宙 谁能建立先发优势?

- 中新经纬|反向带货还是饥饿营销,瑞幸李国庆互怼伤害了谁?

- 物流|市占率全球第一,引领行业变革,深圳这个独角兽企业分享经验

- 代码|周鸿祎:不理解35岁被职场抛弃,中国人35岁就老了?程序员年纪越大经验越丰富

- 新浪科技|视频|李东生获十大经济年度人物,眼眶湿润 几近哽咽落泪

- 新浪科技综合|中国学者找到新生儿黄疸与空气污染的关系 建预测模型

- 澎湃新闻|“漠河舞厅”商标被经销公司抢注,当前状态为“等待实质审查”

- 科技|华数集团战略合作部·华数传媒网络余浙东总经理参观云针科技

- 21世纪经济报道|荣耀推出首个高端折叠屏手机,京东方、沃特股份亮明合作关系

- 幽门螺旋杆菌|“抗幽牙膏”坑人的“生意经”