#fit|拓端tecdat|R语言Stan,JAGS用rstan,rjags建立贝叶斯多元线性回归预测选举数据

原文链接:http://tecdat.cn/?p=21978

本文将介绍如何在R中用rstan和rjags做贝叶斯回归分析 , R中有不少包可以用来做贝叶斯回归分析 , 比如最早的(同时也是参考文献和例子最多的)R2WinBUGS包 。 这个包会调用WinBUGS软件来拟合模型 , 后来的JAGS软件也使用与之类似的算法来做贝叶斯分析 。 然而JAGS的自由度更大 , 扩展性也更好 。 近来 , STAN和它对应的R包rstan一起进入了人们的视线 。 STAN使用的算法与WinBUGS和JAGS不同 , 它改用了一种更强大的算法使它能完成WinBUGS无法胜任的任务 。 同时Stan在计算上也更为快捷 , 能节约时间 。

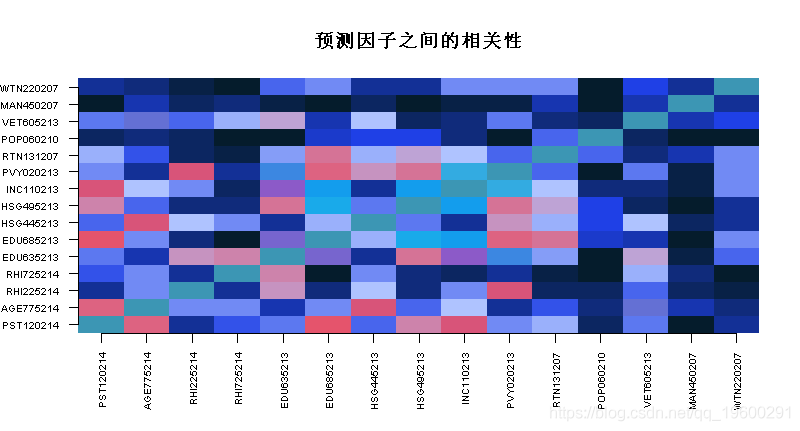

例子 设Yi为地区i=1 , … , ni=1 , … , n从2012年到2016年选举支持率增加的百分比 。 我们的模型

文章图片

式中 , Xji是地区i的第j个协变量 。 所有变量均中心化并标准化 。 我们选择σ2~InvGamma(0.01,0.01)和α~Normal(0100)作为误差方差和截距先验分布 , 并比较不同先验的回归系数 。

加载并标准化选举数据

- # 加载数据

- load("elec.RData")

- Y <- Y[!is.na(Y+rowSums(X))]

- X <- X[!is.na(Y+rowSums(X)),]

- n <- length(Y)

- p <- ncol(X)

p

## [1] 15

- X <- scale(X)

- # 将模型拟合到大小为100的训练集 , 并对剩余的观测值进行预测

- test <- order(runif(n))>100

- table(test)

- ## test

- ## FALSE TRUE

- ## 100 3011

- Yo <- Y[!test] # 观测数据

- Xo <- X[!test,]

- Yp <- Y[test] # 为预测预留的地区

- Xp <- X[test,]

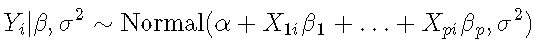

- boxplot(X, las = 3

文章图片

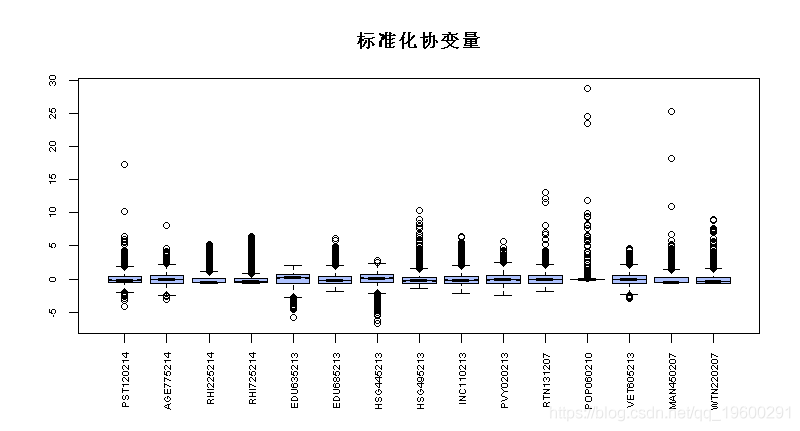

image(1:p, 1:p, main = "预测因子之间的相关性")

文章图片

rstan中实现 统一先验分布

如果模型没有明确指定先验分布 , 默认情况下 , Stan将在参数的合适范围内发出一个统一的先验分布 。 注意这个先验可能是不合适的 , 但是只要数据创建了一个合适的后验值就可以了 。

- data {

- int<lower=0> n; // 数据项数

- int<lower=0> k; // 预测变量数

- matrix[n,k] X; // 预测变量矩阵

- vector[n] Y; // 结果向量

- }

- parameters {

- real alpha; // 截距

- vector[k] beta; // 预测变量系数

- real<lower=0> sigma; // 误差

- rstan_options(auto_write = TRUE)

- #fit <- stan(file = 'mlr.stan', data = https://www.sohu.com/a/dat)

文章图片

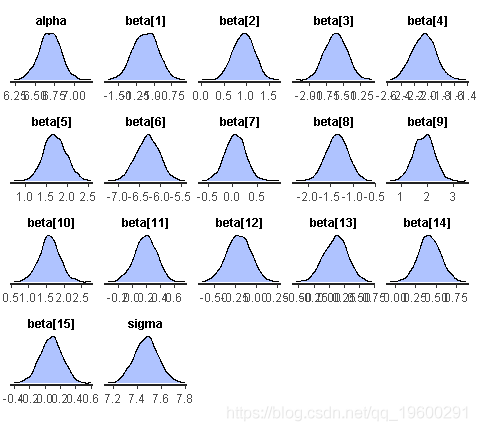

hist(fit, pars = pars)

文章图片

【#fit|拓端tecdat|R语言Stan,JAGS用rstan,rjags建立贝叶斯多元线性回归预测选举数据】dens(fit)

文章图片

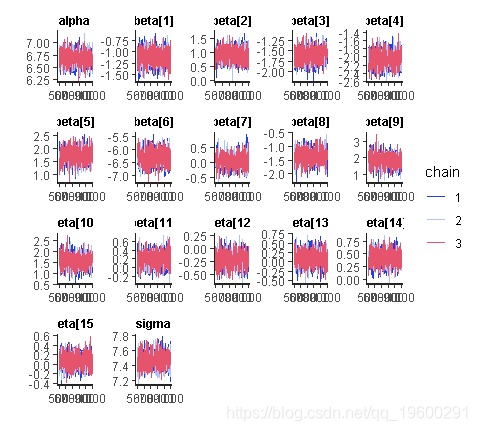

traceplot(fit)

文章图片

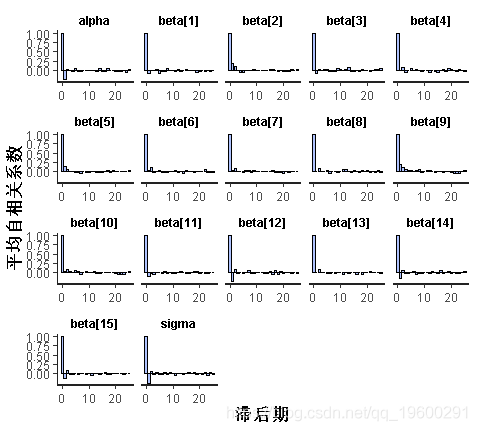

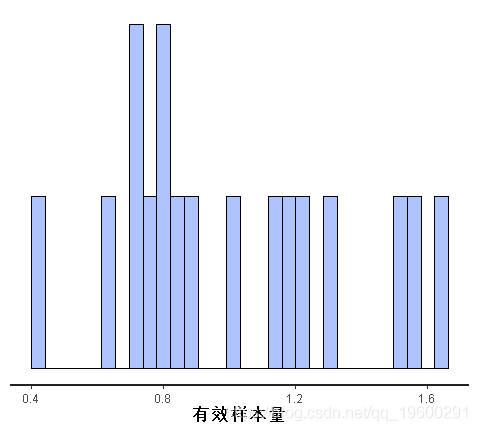

文章图片

文章图片

文章图片

文章图片

文章图片

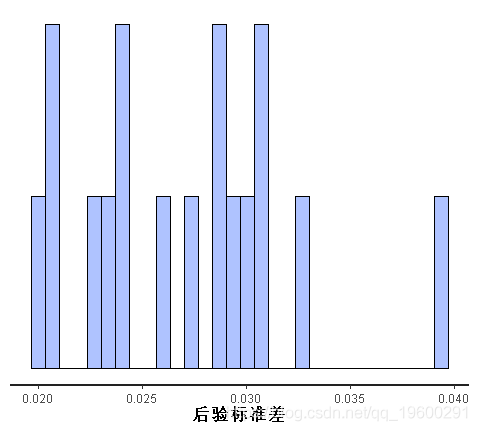

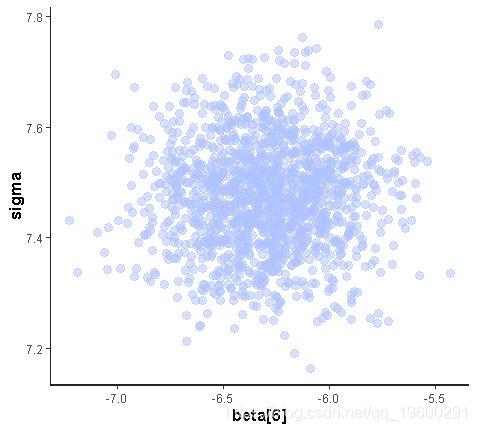

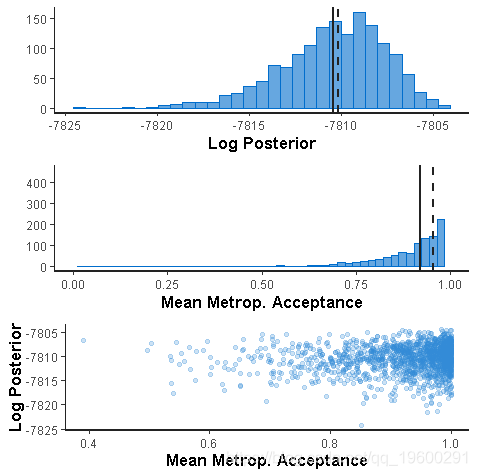

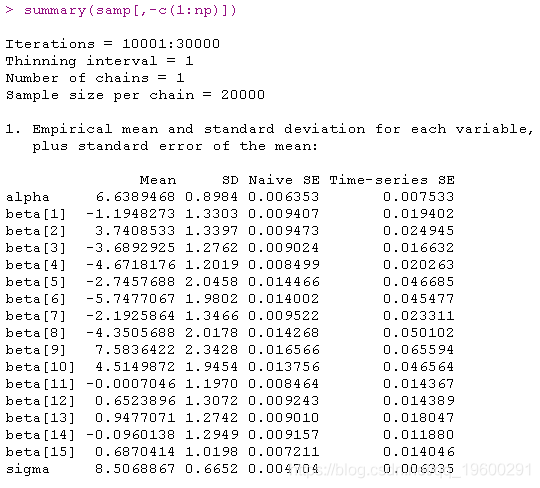

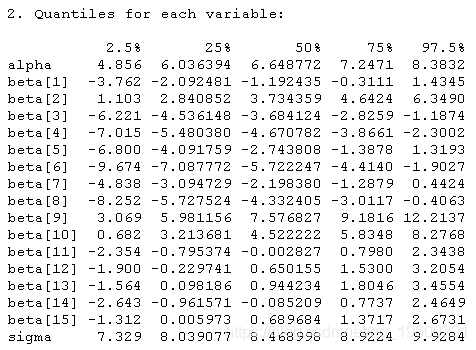

rjags中实现 用高斯先验拟合线性回归模型

- library(rjags)

- model{

- # 预测

- for(i in 1:np){

- Yp[i] ~ dnorm(mup[i],inv.var)

- mup[i] <- alpha + inprod(Xp[i,],beta[])

- # 先验概率

- alpha ~ dnorm(0, 0.01)

- inv.var ~ dgamma(0.01, 0.01)

- sigma <- 1/sqrt(inv.var)

- # 注意:Yp不发送给JAGS

- jags.model(model,

- data = https://www.sohu.com/a/list(Yo=Yo,no=no,np=np,p=p,Xo=Xo,Xp=Xp))

- coda.samples(model,

- variable.names=c("beta","sigma","Yp","alpha"),

文章图片

文章图片

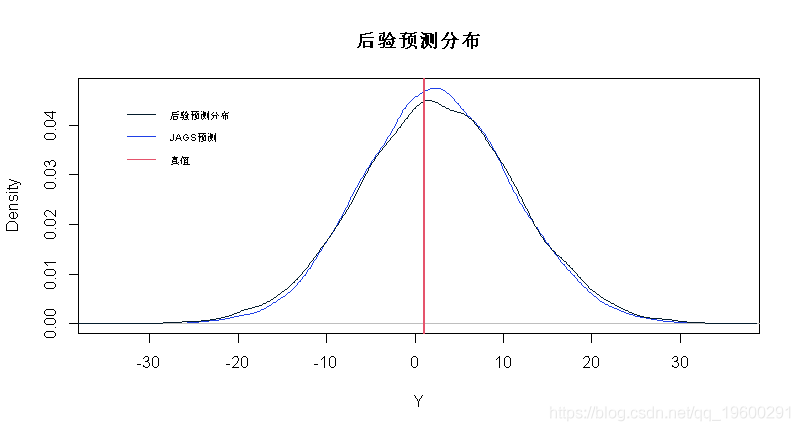

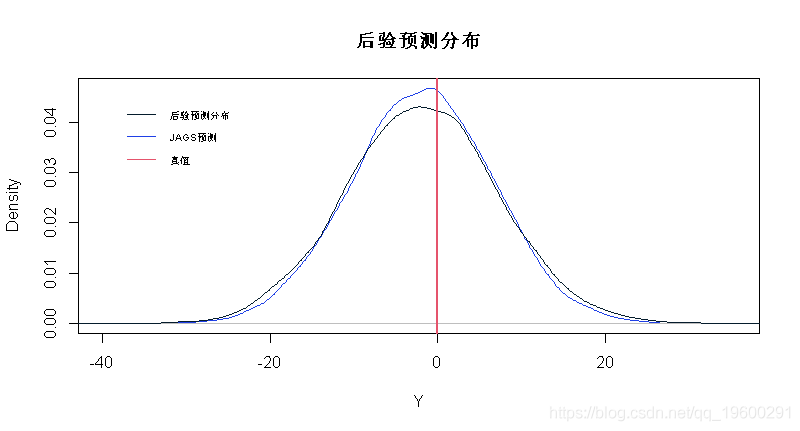

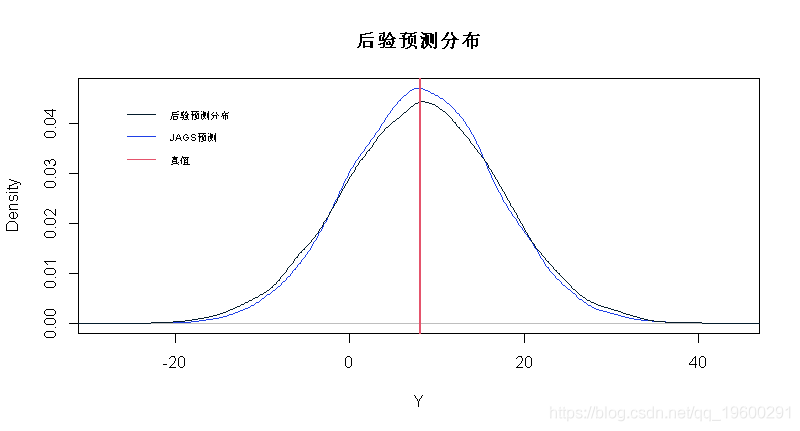

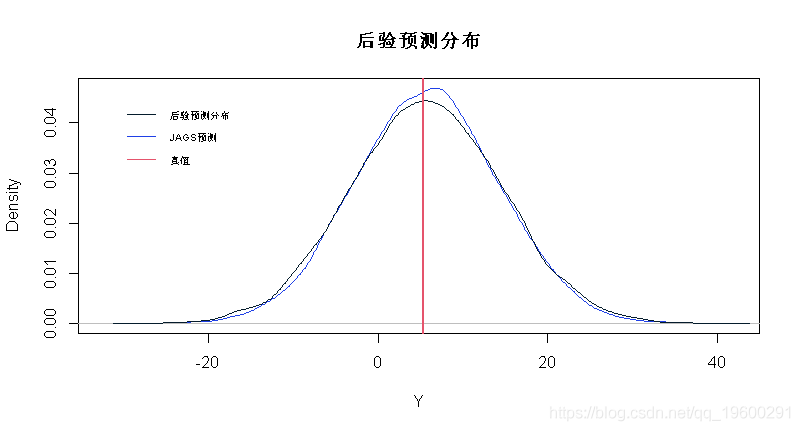

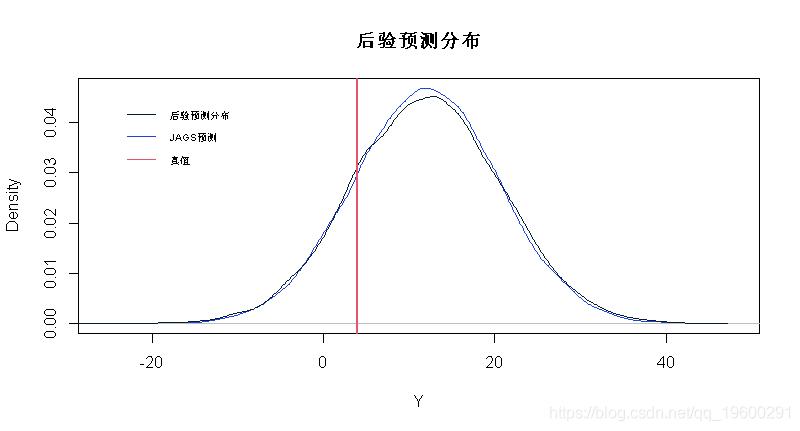

从后验预测分布(PPD)和JAGS预测分布绘制样本

- #提取每个参数的样本

- samps <- samp[[1]]

- Yp.samps <- samps[,1:np]

- #计算JAGS预测的后验平均值

- beta.mn <- colMeans(beta.samps)

- # 绘制后验预测分布和JAGS预测

- for(j in 1:5)

- # JAGS预测

- y <- rnorm(20000,mu,sigma.mn)

- plot(density(y),col=2,xlab="Y",main="PPD")

- # 后验预测分布

- lines(density(Yp.samps[,j]))

- # 真值

- abline(v=Yp[j],col=3,lwd=2)

文章图片

文章图片

文章图片

文章图片

文章图片

- # 95% 置信区间

- alpha.mn+Xp%*%beta.mn - 1.96*sigma.mn

- alpha.mn+Xp%*%beta.mn + 1.96*sigma.mn

- # PPD 95% 置信区间

- apply(Yp.samps,2,quantile,0.025)

- apply(Yp.samps,2,quantile,0.975)

请注意 , PPD密度比JAGS预测密度略宽 。 这是考虑β和σ中不确定性的影响 , 它解释了JAGS预测的covarage略低的原因 。 但是 , 对于这些数据 , JAGS预测的覆盖率仍然可以 。

文章图片

最受欢迎的见解

1.matlab使用贝叶斯优化的深度学习

2.matlab贝叶斯隐马尔可夫hmm模型实现

3.R语言Gibbs抽样的贝叶斯简单线性回归仿真

4.R语言中的block Gibbs吉布斯采样贝叶斯多元线性回归

5.R语言中的Stan概率编程MCMC采样的贝叶斯模型

6.Python用PyMC3实现贝叶斯线性回归模型

7.R语言使用贝叶斯 层次模型进行空间数据分析

8.R语言随机搜索变量选择SSVS估计贝叶斯向量自回归(BVAR)模型

9.matlab贝叶斯隐马尔可夫hmm模型实现

推荐阅读

- 广告|拓端tecdat|移动广告中基于点击率的数据策略

- XTrain|拓端tecdat|matlab使用长短期记忆(LSTM)神经网络对序列数据进行分类

- 分析|拓端tecdat|R语言文本挖掘NASA数据网络分析,tf-idf和主题建模

- 模型|拓端tecdat|R语言多元逐步回归模型分析房价和葡萄酒价格:选择最合适预测变量

- 偏差|拓端tecdat|在Python和R中使用交叉验证方法提高模型性能

- 网络|拓端tecdat|使用Python中Keras的LSTM递归神经网络进行时间序列预测

- 分析|拓端tecdat|stata马尔可夫Markov区制转移模型分析基金利率

- 期望值|拓端tecdat|R语言MCMC:Metropolis-Hastings采样用于回归的贝叶斯估计

- Copula|拓端tecdat|R语言Copula函数股市相关性建模:模拟Random Walk(随机游走)

- 模型|拓端tecdat|R语言RStan贝叶斯:重复试验模型和种群竞争模型Lotka Volterra