文章图片

文章图片

文章图片

文章图片

编辑:LRS 好困

【新智元导读】一篇论文带你读完「连续分片线性函数」的发展 。

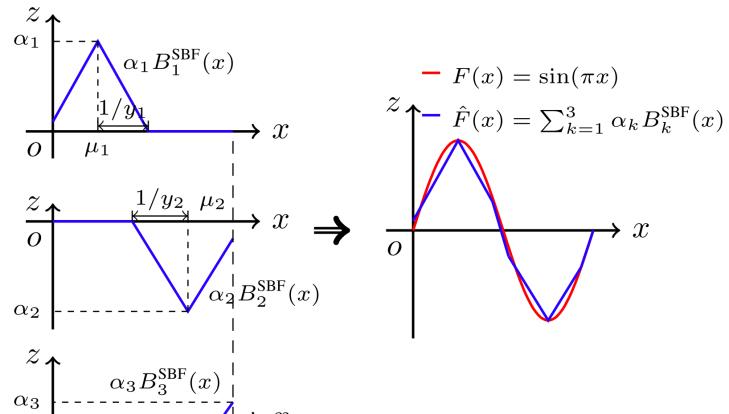

连续分片线性函数是一类具备局部线性特性和全局非线性特性的连续函数 。 具有特定表示模型的连续分片线性函数能够对紧集上的任意连续函数进行全局逼近 。

其本质是利用有限数量的线性函数对复杂的

非线性系统进行精确建模 , 即在保持局部线性特性的同时 , 使整体建模表现出非线性特性 。

分片线性神经网络(PieceWise Linear Neural Networks , PWLNN)是利用连续分片线性函数对非线性系统建模的主要方法之一 。

当合理配置神经网络网络结构及神经元中的

激活函数(如ReLU等分片线性映射函数) , 可以得到一类PWLNN , 并以此为基础 , 灵活利用常见的神经网络模型参数优化算法和各类成熟的计算平台 , 实现对复杂非线性系统或数据集进行黑箱建模 。

在过去的几十年里 , PWLNN已经

从浅层架构发展到深层架构 , 并在不同领域取得了广泛的应用成果 , 包括电路分析、动态系统识别、数学规划等 。 近年来 , 深度PWLNN在大规模数据处理方面取得的巨大成功尤为瞩目 。

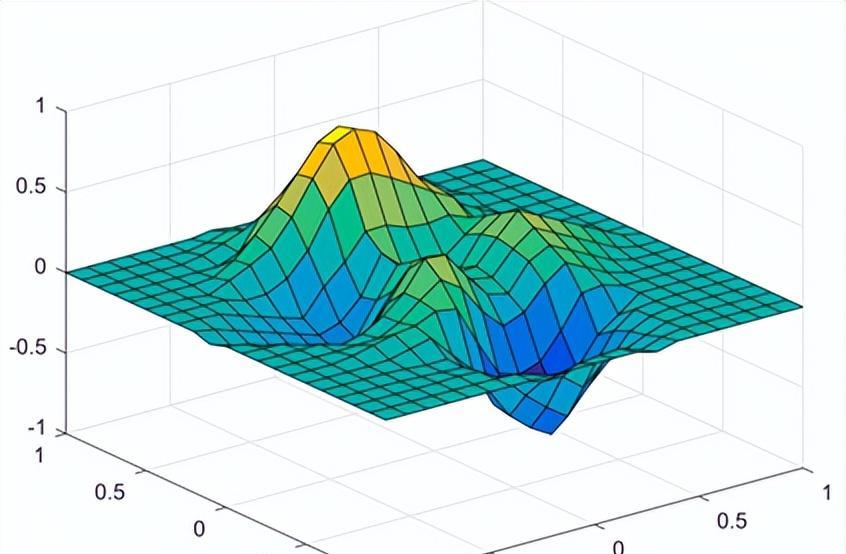

图1 二维连续分片线性函数示例[2

最近由

清华大学自动化系、比利时荷语鲁汶大学电子系、上海交通大学自动化系以及之江实验室的研究人员共同完成的一篇发表在《自然-综述》系列期刊上的综述论文 , 系统地介绍了分片线性神经网络表示模型(包括浅层及深度网络)、优化算法、理论分析以及应用 。

清华大学自动化系

李力教授及王书宁教授指导的博士毕业生陶清华(现任比利时荷语鲁汶大学博士后)、黄晓霖(现任上海交通大学副教授)为论文的通讯作者 , 其中陶清华博士为论文第一作者 , 其他共同作者包括王书宁教授、比利时荷语鲁汶大学Johan A.K. Suykens教授及王书宁教授指导的博士毕业生袭向明(现任之江实验室助理研究员) 。

清华大学自动化系王书宁教授团队近二十年来在分片线性神经网络方向开展了系统的研究 , 取得了一些重要成果 , 显著推进了该领域的发展 。

目前 , 团队成员遍布于国内外的研究机构 , 继续从事分片线性神经网络及其相关科研工作 , 共同促进相关理论的发展和成果转化 。

Nature Reviews Methods Primers于2021年1月创刊 , 致力于加强跨学科的协作 , 出版多领域前沿方法或技术的综述文章 , 旨在为处于不同职业阶段或具有不同研究背景/不同知识储备的跨学科研究者和实践者提供了解、评估和应用前沿方法和技术的信息交流平台 。

基本背景及发展历程

为了将PWLNN更好地应用于数据科学 , 学者们长期以来一直围绕两个基本问题展开研究 , 即

表示模型及其参数学习算法 , 其中前者旨在建立具备分片线性特性和充分的逼近能力的数学模型[2-11

, 后者则研究适应大规模数据的表示模型参数准确而快速的学习算法[9-22

, 从而使PWLNN能够准确描述给定数据或待研究系统对象的特性 。

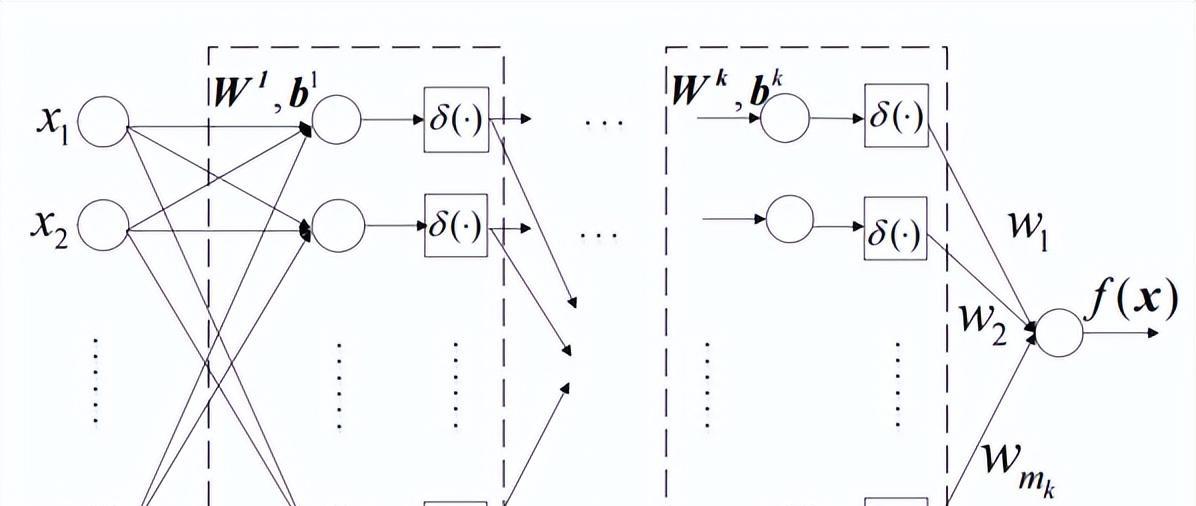

图3. 模型部分概况[1

1977年 , 著名电路系统专家蔡少棠(Leon O. Chua)等在电路系统分析中

首次成功提出了紧凑的PWLNN表示法 , 即典范表示模型[3

。

1993年 , 著名统计和机器学习专家Leo Breiman开创了另一类基于

铰链的模型表示 , 即链接超平面模型[4

, 其与当今深度神经网络中最流行的激活函数之一 , 即线性整流单元(Rectified Linear Units ReLU) , 极为类似 。

随后

王书宁教授将其推广至具有全局表示能力的广义链接超平面模型[8

。

随着典范表示模型和链接超平面模型的提出 , PWLNN相关研究也得到快速发展 , 其中大部分工作围绕浅层网络结构和参数学习方法而展开 。

2010年 , Nair和Hinton提出的ReLU21大幅度提高了深度学习在各种基于数据驱动的任务中的效果 , 使得具有深层网络结构的PWLNN得到更加广泛的关注 。

推荐阅读

- 《前沿》子刊神经科学报道!诱导多能干细胞治疗缺血性中风

- 该领域4本被剔除SCIE的期刊,你知道吗?

- 如果百万吨重的黄金小行星撞击地球,会引发全球金融危机吗?

- 努力在当下,别的都随缘。因为生命本身就是个偶然

- 巴甫洛夫大脑由什么构成?

- 处于地远山险的瑰丽物种,其实就在我们「身边」

- 南佛罗里达大学医学院:通过干细胞疗法可以隔离帕金森病的炎症

- 神秘巨人石像是外星人建造的?运输和打造过程成为谜团,非常艰难

- 韦伯太空望远镜为我们展示了一个前所未见的海王星