【论坛第8期话题】 智能革命与人类深度智能化

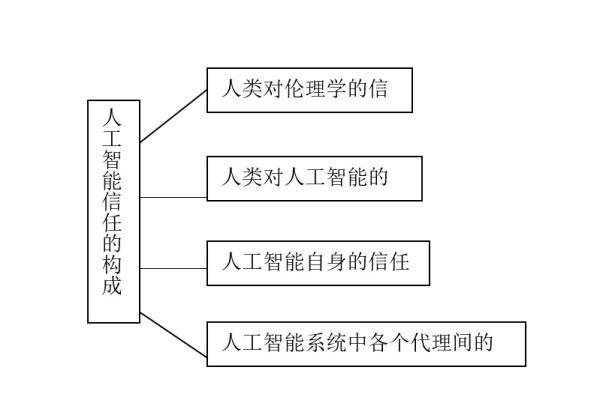

“科技世代与人类未来”论坛第八期聚焦“智能革命与人类深度智能化”主题 , 以北南联袂、京沪对话的方式对谈智能革命在人类生命、行为、认知和情感等层面可能带来的深度影响 。 段伟文研究员在《智能化数据解析社会的政治伦理考量》指出在数据驱动的智能解析社会 , 智能算法实施的是基于预见的干预或可能性政治 , 应从主体能动性出发 , 赋予人们相应的技术能力与自主性权利 , 进而从“生命-智能-社会复合体”的维度 , 审视智能革命与人类社会深度智能化的前景 。 刘永谋教授在《智能革命与机器乌托邦》中提出 , 随着智能技术在治理领域的推进 , 存在着“电子圆形监狱”降临的风险 , 应该认真研究、积极应对 , 避免社会滑入“AI机器乌托邦”;杨庆峰教授在《智能革命与人类记忆》指出 , 把记忆理解为认知和情感产生的前提条件能够使得我们看清人工智能的发展 , 具备记忆的人工智能体具备了一种可能性 , 能够突破技术奇点 , 走向强人工智能;闫宏秀教授的《用信任解码人工智能伦理》一文从信任在人工智能中的产生、表征及其构成等为切入点 , 以人类对伦理学的信任、人类对人工智能的信任、人工智能自身的信任度、人工智能系统中各个代理间的信任等四个要素开启人工智能伦理构成要素之径 , 以有效监督的信任为前提审视人与人工智能的合作 , 确保人工智能向善 。

智能化数据解析社会的政治伦理考量

段伟文(中国社会科学院)

近年来 , 人工智能应用的热点是数据智能 , 其主要背景是世界的数据化 。 所谓世界的数据化 , 简单地讲就是:世界就是数据 , 数据就是世界 。 什么是数据?英文中的数据一词是data , 但其内涵不仅与数字或科学观测有关 , 更是对世界的记录 。 当初傅统先在译杜威的《确定性的寻求》时 , 将data翻译为素材 。 当前 , 我们所说的大数据和数据智能中的数据的含义就是素材 , 更确切地讲是电子化的素材 , 比方说报告的录音、录像等 。 有些素材的元数据是可以量化和结构化的 , 这些数据起到了测量世界和人的行为过程的作用 。 近年来 , 由于素材或数据存储与处理的成本不断降低 , 我们能够把很多东西记录下来 , 虽然记录的时候有各种各样的目的 , 一旦记录下来以后就可以变成素材而用于别的用途 , 如可作为其他主题的数据挖掘之用 。 值得指出的是 , 当我们讲“世界就是数据”和“数据就是世界”时 , 应该看到所谓的世界的数据化并不是抽象的 , 用数据呈现世界和人的行为的方式取决于具体的记录、传感、测量和分析技术 , 而任何方式都会突出与强化世界与人的行为的某些方面而忽视与弱化另一些方面 。

数据智能和智能算法的应用是现代社会治理与个人治理日益量化的最新表现 , 这一趋势与发端于17世纪的“政治算术”、始于19世纪的“控制革命”密切相关 , 其新近的发展正在导致“解析社会”的来临 。 首先 , 所谓政治算术可以追溯至17世纪刚兴起的统计学的社会应用 。 当时 , 统计学的社会应用的倡导者将统计学称为“政治算术” , 当时的哲学家和古典经济学家威廉·配第还专门写了本题为《政治算术》的小册子 , 以强调统计数字对于政治具有至关重要的作用 。 其次 , 使政治算术的理念得以普遍推行的则是被称为“控制革命”的信息技术的发展 。 20世纪80年代 , 信息技术史家贝尼格(James R. Beniger)在《控制革命》一书中指出 , 19世纪以来 , 信息技术的发展实质上是为了克服由城市化和大工业生产所带来的控制的危机而形成的一系列控制革命 。

20世纪的最后30年间 , 伴随着对以工业化为特征的现代化的弊端的反思 , 微电子、个人计算机、网络和移动通信等信息通信技术的发展为信息化开辟了道路 , 其间不仅涌现出后工业社会和第三次浪潮等社会理论与未来学思潮 , 而且还由反主流文化孕育出为虚拟空间奠基的赛博文化 , 其结果导致了20世纪末具有虚拟性、匿名性和多主体交互性的网络空间的崛起 。 但这种貌似个体可以通过虚拟的网络空间摆脱现实社会制约的幻象很快就破灭了 。 随着谷歌搜索对百科全书检索式的雅虎等早期门户网站的超越以及Web2.0和网络社交新媒体的发展 , 用户网络活动所生成的内容即UGC(User-generated content)不仅使网络为用户数据所驱动 , 而且这些数据反过来成为人们的数据足迹 。 随着移动互联网、网络社交媒体、智能手机、可穿戴设备等信息技术的发展和各种数据的指数化增长 , 对人的线上和线下行为数据的搜集和分析则可能使每个人成为被追踪、观测、分析的对象 , 数据的掌握者由此可对数据进行认知计算 , 借助一定的算法对数据主体展开行为评分和内容推荐 , 从而对人的行为进行评判、引导和干预 。

不论是运用数据表征或干预世界和人的行为 , 还是运用各种可穿戴设备对数据采集与分析对他人或自己的生活进行量化自我等管理与治理 , 都预示着一个全新的社会———解析社会或数据解析社会的来临 。 数据解析社会这种新的社会形态是革命性的 。 一方面 , 数据所扮演的角色如同13世纪时出现的透镜 , 如果说透镜所制造的望远镜和显微镜让宇宙和微观世界得以清晰地观测与呈现 , 如今“数据透镜”则使人的行为得到量化的记录与透视;另一方面 , 就像17世纪笛卡尔发明解析几何使得自然界的结构与规律得以探究一样 , 数据分析与智能算法的应用正在使人的行为规律得到洞察和解析 。

不论数据解析社会的构建如何展开 , 智能算法对人们生活的影响已无处不在 。 从企业对员工的评价、人事简历自动筛选、商业信用评分到区域犯罪预测、城市警力分布、自我健康管理 , 数据分析与智能算法在人们生活中涉及的各种评价、筛选和决策中日渐扮演着举足轻重的角色 , 我们业已步入由算法规制生活和引导人的行为的算法生活时代 。 政府和企业为了各种目的在其管理和运营中引入了很多智能算法 , 这些算法在执行中会形成各种影响人的生活的算法权力 。 这种算法权力很容易遭到滥用 , 甚至会发展为所谓的算法霸权 。 首先 , 姑且不提算法可能存在的黑箱问题(不透明、不易解释等) , 供机器学习的数据 , 如大量罪犯行为数据本身是由人记录和处理的 , 本身就带有人的各种偏见(如种族偏见、社区偏见等) , 在此基础上所进行的算法决策很容易使这些偏见放大 。 其次 , 智能算法往往只考虑到某些特定的视角而缺乏整体性的思考 。 其三 , 智能算法中存在的不合理之处往往缺乏反馈与纠正的渠道 , 如果不能引入受到算法权力伤害或不公正对待的人能够及时参与的反馈纠错机制 , 算法的主导者很难主动发现问题并加以反思和修正 。

进一步而言 , 智能算法的应用建立在一种基于预见的可能性而采取控制行动的政治逻辑之上 , 我们可以称之为可能性的政治 。 在斯皮尔格导演的电影《少数派报告》中对未实施的犯罪的阻止甚至惩罚虽然不一定发生 , 但数据分析和智能算法的控制者显然会用它们来预测、引导或阻止人的行为 , 不论其方式是柔性的计算机说服技术或智能化助推 , 还是刚性的简历筛选和对行动自由的限制 , 都体现了某种宰制性的权力或霸权 。 以所谓人的数据画像为例 , 虽然人的数据画像如同人的“数据孪生兄弟” , 但其本身是没有主体性和能动性的 , 而只是体现了数据分析与智能算法的掌控者对数据画像的对象的主体性或能动性的猜测 , 其中所折射的是他人的主体性、能动性或意向性 。 因此 , 数据孪生兄弟实际上是缺失心灵的数据僵尸 。

由此 , 要克服数据分析与智能算法的数据霸权与算法权力 , 应该从主体的能动性构建出发 , 使人的主体性、能动性或意向性免于被数据僵尸所取代的命运 。 这就要求我们通过与数据霸权与算法权力的缠斗寻求人的能动性与算法权力关系的再平衡:始终从使用者或人的角度去评判智能算法的合理性;智能算法应发挥普遍性赋能作用 , 使每个人的能力增强 , 权利也得到相应扩充;人与算法要建立起一种伙伴关系 , 即 , 使智能算法成为陪伴人、帮助人的伴侣技术 。

【世代|科技世代与人类未来丨智能革命与人类深度智能化】最后 , 值得指出的是 , 智能原本源自生命与社会 , 生命、智能与社会共同构成了日益复杂的生命-智能-社会复合体 。 从“生命-智能-社会复合体”这一分析框架出发 , 有助于总体把握智能革命以及人类社会深度智能化的前景:人工智能体将以拟主体的形式整合到生命 - 智能 - 社会复合体之中 , 泛主体社会或泛智能体社会即将来临 。 当我们面对陪伴机器人、智能音箱以及层出不穷的智能体或泛主体时 , 将会越来越多地思考它们是什么样的拟主体 , 又具有什么意义上的能动性 。

原载于《山东科技大学学报》2019年第1期 。

智能革命与机器乌托邦

刘永谋(中国人民大学)

智能革命与技术治理的关系是一个大题目 。 智能革命已经到来 , 这个提法是站得住脚的 。 学界提出的各种“革命”太多 , 就工业革命而言 , 有人都提到第六次工业革命了 。 实际上 , “革命”不过是一个隐喻 , 能不能成立并不重要 , 重要的是提出这个“革命”要表达什么 , 是否有价值 。 显然 , 智能革命会大力推动整个社会技术治理的程度和水平 , 同时会导致社会风险 。 智能革命社会风险包括运用智能技术的智能治理风险 , 不是科学技术本身的问题 , 根本上是政治、制度和实践问题 。 关于这个问题 , 技术哲学荷兰学派如佛贝克等人力推的道德物化的角度很有启发性 , 但道德物化处理的问题过于细节 , 大的问题还是要借助制度安排来应对 。

智能革命和AI技术对社会公共治理会有什么样的影响?对此问题 , 大家都是基于智能革命和AI技术充分发展的远景来回答的 。 答案存在两种相反的极端态度:一种是乐观主义的 , 像成素梅教授那样 , 认为以后可能出现一个“AI理想国”;还有一种是悲观主义的 , 可以称之为“AI机器乌托邦” 。 这里先讨论一下悲观的想法 , 过后再讲乐观的想法 。

很多人都讨论过物联网和大数据对于技术治理的推动作用 。 家用的小米机器人 , 它要在家扫地 , 当然要搜集和分析房间的信息 , 也就是说 , AI应用离不开物联网和大数据 , 如果后两者对技术治理有推动 , 那么AI对技术治理的推动就不言而喻了 。

悲观主义者总是担忧智能治理和AI治理:智能革命时代 , 电子圆形监狱(electronic panopticon)会不会到来?大家研究信息哲学 , 都知道边沁和福柯提出的圆形监狱理论 , 以及后来流行的电子圆形监狱概念 。 用圆形监狱理论分析物联网的结构与功能 , 会发现物联网会偏好极权控制 , 因而本底上是会侵犯人的隐私的 。 在具体意象上讲 , 就是小说《1984》中无处不在的电幕 , 对所有人进行监视 。 这主要考虑的是物联网隐私问题 , 到了AI技术和智能革命的时代 , 这就不光是一个隐私问题 , 除了监视 , 机器人当然是可以诉诸实际行动的 , 比如对人进行拘押 。 机器人收集和行动的能力如果扩展到社会公共事物和政治领域的时候 , 会产生比电子圆形监狱更强的负面效应 。 换句话说 , 到了智能革命时代 , 电子圆形监狱才可能成为真正的监狱:从监视、审判到改造可以一体化完成 。 也就是说 , 电子圆形监狱会不会成为机器乌托邦?这就是当今敌托邦科幻文艺的一个大类 , 即“AI恐怖文艺”所要抨击的景象 , 在好莱坞电影《终结者》系列中得到最著名的呈现:机器人对所有人的牢狱统治 。

当然 , 所谓隐私是社会建构的 , 是历史变化的 , 是有地方性的 。 为什么当代中国人越来越讲隐私 , 但同时很多人在朋友圈晒自己的私密生活?这说明没有普遍的一致的隐私 , 隐私观是很不同的 。 在中国古代 , 人们是缺少隐私观念的 , 或者说隐私观念是很不同的 。 古人讲 , 不发人阴私 , 这不是说尊重人权 , 而是说要做君子 。 中国古代最高权力者皇帝是没有隐私的 , 他的一举一动都在《起居注》中记载得清清楚楚 。 旧式大家族中人们同样没有隐私 , 年轻人要早晚向父母请安 , 什么事情宗族都会知道、要干预 。 隐私与人权有关 , 中国传统是没有这个概念的 。 奇怪的是 , 没有隐私 , 数千年来中国社会治理和社会生活大体运行得也很平稳 。 实际上隐私观在中国就是随着ICT技术和网络兴起传到中国来的 , 在80年代都很少有中国人讲究隐私 。 随着物联网和大数据技术的推进 , 中国人还在形成中的隐私观很快会发生改变 , 比如很多人现在出门在“去哪儿”APP上定房间、安排行程 , 把个人信息让商家知道 , 觉得很方便 。

隐私社会建构论实际上并没有否定物联网偏好极权的观点 。 隐私观的改变 , 从某种意义上说是对技术发展的屈服 。 然而到了智能革命时代 , 极权的触角可能伸到的地方不再仅仅是看 , 而是会有具体的行动、对肉体和思想的严格控制 。 如果电子圆形监狱在社会上广泛建成的时候 , 这就是所谓的最坏的智能治理社会 , 即“机器乌托邦”就会到来 。 也就是说 ,AI技术是有可能催生机器乌托邦的 。

机器乌托邦会是什么样的?通过对批评既有的技术治理、智能治理以及AI在社会公共领域应用的各种思想文献来进行分析 , 可以得出它的基本意象 。 当代西方的科幻小说有个很重要的特点 , 即乐观主义情绪很少 , 并且基本上都与对智能革命的想象有关系 。 这样一种想象在西方是很流行的 , 它所勾勒出来的未来社会是一架完整、严密和智能的大机器:由于 AI技术的广泛应用 , 每个社会成员都是这个智能机器上的一个小智能零件 , 而且是可以随时更换的零件 , 和钢铁制造的零件没有差别 , 这就是“AI机器乌托邦” 。 以好莱坞为代表的科幻影视 , 对此有各种各样的刻画 。

从批评的文献、文艺和影视作品中 , 可以归纳出AI机器乌托邦的四个主要特点 。 第一个是AI机械化 , 即把人、物、社会所有都看成纯粹机械或智能机器 , 对所有的一切要事无巨细地进行智能测量 , 包括人的思想情感 , 可以还原成心理学和物理学的事实以此来进行测量 。 第二个是AI效率化 , 也就是说 , AI机器乌托邦它核心的价值主张是效率 , 智能要讲求效率 , 科学技术是最有效率的 , 没有效率的东西比如文化、文学和艺术都是可以取消 。 AI机器乌托邦社会运行的目标就是科学技术越来越发达 , 物质越来越丰富 , 人类文明不断地扩展 , 要扩展到整个地球 , 扩展到月球 , 扩展到火星 。 第三是 AI总体化 , 也就是说整个社会是一个智能总体 , 按照建基于物联网、大数据、云计算和AI等智能技术之上的社会规划蓝图来运转 。 所有国家政党、社会制度、风俗习惯以及个人生活全面被改造 , 没有人能够逃脱总体化的智能控制 。 第四是AI极权化 , AI机器乌托邦是反对民主和自由的 , 认为民主和自由没有效率 , 支持的是由智能专家、控制论专家掌握国家大权 , 公开实现等级制度 , 然后以数字、智能和控制论的方式残酷地统治社会 。

用AI技术对社会进行公共治理是不是就必然会导致机器乌托邦呢?不一定 , 因为所有的技术治理包括智能治理可以有很多不同的模式 。 一种是激进的 , 整个社会要打乱重新按照智能蓝图来建构;另一种是温和的 , 在现有的基础上进行改良 , 而温和派之间也有很大差别 , 所以历史上是有很多不同的技术治理模式 。

对AI机器乌托邦意象的总结有何教益?西方对智能治理、AI治理的批评 , 我们并不完全赞同 , 但是从理论上考虑 AI机器乌托邦的危险或风险是很有必要的 。 在历史上并没有真正出现过AI机器乌托邦 , 它还只是在人们恐惧的想象中 , 但是从理论上说它还是可能出现的 , 因此要避免极端的AI机器乌托邦的出现 。 上述AI机器乌托邦意象的四种特征 , 是要在AI技术、智能技术应用于社会公共治理的过程中极力避免的 , 当然这是非常复杂的问题 。 这里有一些初步的思考 , 比如要避免AI总体化 , 必须要避免封闭性智能社会 , 实际上封闭性在网络社会是很难完全做到的;比如避免AI机械化 , 涉及社会主流观念尤其是科学观的改变 , 一百年前主流的科学观是机械主义的 , 现在并不如此;比如避免AI极权化 , 关键是选择适当的智能治理模式 , 不一定和自由民主相冲突 。 奥尔森指出 , 技术治理在21世纪有“软”化的趋势 , 不像以前那么“硬”了 。 比如 , 要避免AI经济至上的观点 , 社会局部的规划要服从更高制度的安排 , 智能治理不能成为惟一或最高的治理安排 , 而应该是作为一种局部的工具 。 总之 , 智能革命的到来加大了AI机器乌托邦的风险 , 因此必须考虑制度设计与应对 , 这个问题从根本上说不是技术问题 , 而是政治问题 。

原载于《山东科技大学学报》2019年第1期 。

智能革命与人类记忆

杨庆峰(复旦大学)

对人工智能的讨论需要放置到人与技术的关系框架中进行 。 首先要做的是对人与技术的关系框架进行反思 。 传统的观点是“工具论” , 即把包括人工智能在内的技术当做一种工具或者对象 , 用来解决问题或者处理一些其他的事情 , 这种人与工具形成非常固定的模式 , 成为我们分析人与技术关系的主导模式 。 “工具论”模式背后是一个主体、客体分离的理论基础 。 这种传统模式后来受到了很多哲学家的严厉批判 , 如海德格尔、芬伯格等人对这一观点进行了很深入的批判 。 海德格尔在批判的基础上提出了现象学的模式 , 而芬伯格把政治维度和社会因素加进去了 。 他们的批判导致了另外一种关系模式“居中说”(人在世界之中、人在技术之中) , 这为本文“旋涡论”的提出奠定了理论前提 。

旋涡论 , 即人在技术的漩涡之中 。 从词源学角度看 , 旋涡的英文是volution , 依次词根会出现三个变形词:convolution、evolution和revolution 。 这三个词恰好可以用来描述与人工智能有关的过程或状态 。 Convolution是卷积或卷绕 , 可以用来描述人工智能内部的算法机制 , 比如卷积神经网络算法(CNN)用来图像识别 。 Evolution是进化 , 可以用来描述智能本身是进化的过程 。 Revolution则是革命或旋转 , 可以用来描述智能本身是革命的过程 , 如技术奇点 。 所以“旋涡论”能够很好地描述人与智能机器的关系 , 又能够描述智能的内在机制 , 更重要的是有助于我们在人与智能技术的漩涡当中反思如何在进化与革命之间保持自身并构建其自由关系 。

从记忆哲学分析人工智能是本文采用的一个新角度 。 人类记忆不是宏大的生存层面的东西 , 而是人类学里非常重要的一个规定性 。 在哲学人类学当中 , 康德提出了五感实际上就隐含着一种记忆的概念 , 只不过在他的哲学人类学当中多谈到的是五感知觉 [1] , 对记忆也谈到了 , “将过去有意地视觉化的能力是记忆能力 , 把某物作为将来视觉化的能力是预见能力 。 ” [2]但只是蜻蜓点水 , 一笔带过 。

那么何为记忆?从传统哲学角度看 , 存在着四种理解路径 。 第一种构成路径 , 即把记忆当做灵魂实体的构成部分 , 讨论记忆是在人理性的层面当中还是感性层面当中 。 第二种是能力路径 , 即把人类记忆的解释当做一种精神性的或者灵魂性的能力 , 比如说人类具有一种回想能力 。 第三种是状态路径 , 即把记忆看做是意识或者心理状态之一 。 这种观点持续的时间非常长 , 一直持续到20世纪 。 心理学家普遍认为记忆是心理状态 , 和感知、情绪是相并列的状态 。 对这种心理学的理解后来胡塞尔、伽达默尔都提出批判 。 第四种是行为路径 , 即把记忆看做是意识行为 。 比如说构造过去对象的一种行为 , 或者说使得过去当下化的这样一种行为 。 哲学观点的一个显著特征是将记忆看做是灵魂的特定属性 。

有一些心理学家提出一种新的理解叫“精神性的旅行” , 用这种方式来解释人类的记忆 。 整个心理学的理解可以纳入到哲学的第二层理解当中 , 它属于精神的一种能力 。 但是随着神经科学发展 , 哲学观点受到了自然科学观点的反驳 。 神经科学则提出了记忆作为大脑信息过程(编码、存储和提取)的三阶段理论 。 与记忆的维度相对的是“遗忘” , 它实际上被看作是记忆的对立面 , 这是个通常的观点 。 比如说灵魂构成的丧失或者记忆能力的丧失、状态的失控 , 这时候就把遗忘看作是自然能力的丧失 。 这些观点都是建立在物质基础之上 。

要审视人工智能与人的关系 , 仅仅是传统哲学和神经科学中的记忆理论是不够的 , 还需要新的理解 。 本文提出记忆作为条件的理论 。 这一理论源头在于布伦塔诺和胡塞尔等人 。 在笔者看来 , 记忆作为三种条件形式存在:认知与情感的基础条件、理解人类自身的历史条件和实现自我和他者认同的条件 。 第一 , 记忆是认知和情感产生的基础条件 。 如果没有了记忆这样的基础维度 , 实际上情感和认知是不可能的 。 第二 , 记忆是理解人类自身的历史条件 。 这是关于一种人类历史的构建 , 比如说怎么去面对历史 , 这时候就需要回忆把它构建出来 。 第三 , 记忆是实现自我及其他人认同的必要条件 。 这具体到个体来说实际上是对自我的认同 。 我们能够知道我是谁 , 又通过怎么样的方式去知道我是谁 。 在这个过程当中 , 传统认识论和知识论的学者认为认知起了非常重要的作用 , 但是记忆与回忆的作用不容忽视 , 回忆包括记忆实际上是另外一个不可忽视的条件 , 但在通常的哲学史当中把记忆放在了认知底下其作用完全被忽略掉 。

当采取记忆哲学维度去看 , 人工智能是进化的过程还是革命的过程的问题就可以获得解答的可能性 。 从前面所提到的三个条件来看对这问题就可以做一个有效回答 。 如果把记忆理解成信息的编码、存储、提取这样一个过程 , 那么人工智能是无法从进化突变到革命的 , 就没有革命 , 只有一种进化 。 但如果进一步把记忆理解为认知和情感产生的前提条件的话 , 实际上就具备了一种可能性 , 就说它能够突破技术奇点 。

更重要的是 , 记忆和回忆的关系问题没有受到重视 , 因为太多的理解强调记忆作为信息的编码、存储和提取过程了 , 以至于把回忆的维度给忽略掉 。 回忆是人类特有的一种现象 。 亚里士多德就指出来说动物和人可以拥有记忆 , 但是唯独人才能拥有回忆 。 从他的观点看 , 人工智能是不可能拥有回忆的 , 因为它与动物一样 , 缺乏足够强大的意向性 。 所以人们这时候就不用担心它有一天会超越人 。 但是在笔者看来 , 如果把回忆维度考虑进去 , 这个问题就有无限的可能性了 。 具有回忆能力意味着机器具有了重构过去经历的能力 , 具有了重构过去经历的可能性 。 换句话说 , 对人工智能机器而言 , 它具有经历 , 意味着它具有了过去的时间概念 。 这远远不同于只是信息保存和提取的记忆过程 , 而是能够将过去当下化的过程 。 最近人工智能学者阿尔伯特·艾如斯勒姆(Albert Ierusalem )也指出了人工智能可能会具有自身的经历 。 “基于经历(experience) , 如果系统能够在每一个环境中选择正确的行动 , 这使得计划变得不必要 。 ” [3]人工智能能够感知世界这已经成为常态 , 只是人工智能回忆自身的经历却是一个具有挑战的事情 , 不仅仅是关系到技术怎么去实现 , 比如说让机器去回忆世界 , 更重要的是会涉及到人工智能的革命性突破 。 如果能够实现这点的话那么人工智能走向强人工智能会成为一个必然 。

[1] 康德哲学人类学著作中提到第一类感觉包括触觉(touch, tactus)、视觉(sight, visus )、听觉(hearing, auditus)第二类感觉包括味觉(taste, gustus)、嗅觉(smell, olfactus) , 统称为五感 。 Immanuel Kant, Anthropology from a Pragmatic Point of View, Translated by Victor LyleDowdell, Revised and Edited by Hans H. Rudnick, Southern Illinois University Press, 1996:41.

[2] Ibid, 73.

[3] Albert Ierusalem, Catastrophic Important of Catastrophic Forgetting, https:// arxiv. Org/pdf/1808.07049.pdf, 11 [2018-10-9]

原载于《山东科技大学学报》2019年第1期 。

用信任解码人工智能伦理

闫宏秀(上海交通大学)

人工智能伦理是人工智能未来发展的锚定桩 。 其包括对人工智能相关伦理问题的批判性反思 , 对人工智能的伦理目标厘清与界定 , 以及伦理自身效用等的审度 。 有效的人工智能伦理被视为推进人工智能向善、确保人类对其可控及不受伤害、确保人类尊严与人类福祉的一个重要保障 , 但人工智能伦理的构建并非易事 。 关于伦理应当发挥何种作用、如何发挥作用、以何种伦理观念为指导等的争议一直不断 。 如 , 就在2019年3月到4月之间 , 谷歌关于外部专家委员会(Advanced Technology External Advisory Council , 简称ATEAC)的成立 [1]、谷歌部分员工对外部专家委员会的抗议等 [2]一系列事件就凸显了人工智能对伦理的期待 , 以及人工智能伦理构建所面临的挑战与问题 。 特别是人工智能发展所呈现出的能动性、自主性等技术特质 , 将主体与客体的边界逐渐消融 , 将关于人对技术的信任、人与人之间的信任、人与技术之间的信任等置于了一种前所未有的场景之中 。

一、信任:人工智能的一个核心问题

关于人工智能伦理的研究 , 早在二十世纪六十年代 , 就已经展开 。 如 , 温纳(Nobert Wiener)在其关于自动化的道德问题和技术后果的探讨中 , 揭示了机器的有效性与危险性; [3]随后 , 塞缪尔(Arthur L.Samuel)在《科学》发表文章 , 对维纳所主张的机器具有原创性或具有意志进行反驳 , 进而指出机器不可能超越人类智能 , 并认为维纳将机器类比人类奴隶是不恰当的 。[4]但近年来 , 伴随大数据、机器学习、神经网络等的发展 , 关于机器是否具有原创性或具有意志、人工智能是否能被视为道德主体、以及人工智能是否超越人类的争论日趋激烈 。

这些争论 , 究其本质而言 , 是源自对人能够控制技术并使其能为人类服务这一问题的反思 。 而上述反思至少直接指向了人类对自身信任及对技术是否可信的两个方面 。 简单地说 , 从人类自身的角度来看 , 若人类相信自己能够有效地控制人工智能 , 那么 , 上述问题也将迎刃而解;退一步讲 , 从技术的角度来看 , 若人工智能技术自身是安全可靠那么 , 至少人工智能可以被视为是一项可信的技术 , 而这种可信反过来也将大大推进其的发展 。[5]但若上述两种信任缺失 , 则人工智能的未来发展也不容乐观 。 因此 , 人工智能的信任度是人工智能技术发展中面临的一个核心问题 。 当下 , IBM就以“trusted AI”为其研究目标 , 积极致力于研究构建和能够使人类信任的人工智能 。 与此同时 , 人工智能的信任度也是人工智能伦理构建中的一个核心问题 。

但事实是 , 迄今为止 , 上述两个方面都是假设性的存在 。 如 , 从技术的维度来看 , 以基于人工智能系统的无人驾驶为例 , 就因其在技术方面的不稳健性所引发的诸多问题 , 遭遇到了质疑 。 在这些质疑中 , 也包括关于其的伦理质疑;从关于人工智能伦理构建的维度来看 , 虽然目前尚未形成统一的文本 , 但信任却是与人工智能伦理相关的框架、原则、宣言等文件中的一个高频词 。 如:

2016年底 , 美国电子电气工程学会(IEEE)在其所阐述的“伦理辅助性设计”(Ethically Aligned Design)中 , 将构建人与人工智能系统间的正确的信任层级视为一个重要议题 , 并指出应建立包括标准和规范主体在内治理框架来监督保证过程和事故调查过程 , 进而促进公众对人工智能和自动化系统信任的构筑; [6]2017年7月 , 我国国务院发布了《新一代人工智能发展规划》 。 其中 , “促进社会交往共享互信 。 促进区块链技术与人工智能的融合 , 建立新型社会信用体系 , 最大限度降低人际交往成本和风险”是一项重要的内容; [7]2018年12月18日 , 欧盟委员会由52名来自多个领域的专家所组成的人工智能高级专家组起草了“可信任人工智能的伦理框架”(Draft Ethics Guidelines For Trustworthy AI);经过几个月的意见征询后 , 于2019年4月18日 , 在其发布的《可信任人工智能的伦理框架》(Ethics Guidelines For Trustworthy AI)中 ,[8]将构建可信任作为人工智能未来发展趋势;2019年2月 , 欧洲政策研究中心在其所发布的《人工智能:伦理 , 治理和政策的挑战》”(Artificial Intelligence:Ethics, governance and policy challenges)中 , 认为:在当今社会中 , 人工智能的发展加速了信任的退化 。 因此 , 应当采取行动 , 以推进负责任地和可信任地使用人工智能; [9]2019年6月 , 美国人工智能问题特别委员会、国家科学技术委员会发布了《国家人工智能研究和发展战略计划:2019更新版》( The National AI R&D Strategic Plan: 2019 Update) ,[10]构建信任被列为人工智能未来发展的一项任务;在我国家新一代人工智能治理专业委员会于2019年6月所发布的《新一代人工智能治理原则——发展负责任的人工智能》中 , “安全可控”为第五条原则 , 并指出:“人工智能系统应不断提升透明性、可解释性、可靠性、可控性 , 逐步实现可审核、可监督、可追溯、可信赖 。 ” [11]

综上所述 , 在人工智能伦理的构建中 , 信任被视为是人工智能发展的一个核心问题 。 那么 , 是否可以用信任是解码人工智能伦理呢?关于此 , 需要从信任在人工智能中产生、表征以及构成等为切入点来进行解析 。

二、基于有效监督的信任是人与人工智能合作的必要条件

人工智能的发展带来了一种新型的人与技术关系 。 人类对技术的依赖性越来越高 , 技术成为了人类智能的陪伴 , 并在某些方面呈现出了超越人类智能的趋势 。 伴随人工智能在人类社会中的广泛应用 , 人类与人工智能系统之间的合作日益加强 。 虽然存在没有信任的合作 , 但人与人工智能的这种合作方式因人工智能对人本身以及人类行为深度植入性和巨大影响而必须信任的介入 。 毫无疑问 , 信任的缺失 , 将影响人工智能所能产生的效应 , 但这种信任并非是盲目信任、滥用信任、错误信任等非理性的信任方式 。 恰如皮埃罗·斯加鲁菲(Piero Scaruffi)所示:“我并不害怕机器智能 , 我害怕的是人类轻信机器 。 ” [12]

技术是人类在世的一种方式 。 人类正是借助技术谋求自身的发展 , 离开技术 , 几乎无法去探讨人类的发展 。 也正是在这种谋求的过程 , 人与技术之间信任关系伴随人对技术的依赖而不断被建构起来 。 特别是当今的人工智能 , 更是将人与技术之间的信任关系推向了一个新的高度 。 与此同时 , 对二者之间信任关系的反思也与日俱增 。 如 , 以基于人工智能系统的决策为例 。 在当下 , 人工智能系统为人类的决策提供信息 , 甚或导引人类的决策 。 当人类借助、或者委托、或者授权人工智能进行决策时 , 一种信任就随之而涌现出来 , 且人对人工智能系统的信任度将影响决策 。 假设信任度的阈值为0-1 。 当信任度为0 , 即人类完全不信任人工智能时 , 人类所做出的决策与人工智能系统无关 。 但鉴于人工智能系统在当今的深度植入 , 完全不信任的可能性已然不现实;当信任度为1 , 即人类完全信任人工智能时 , 则人工智能系统所输出的决策就直接等同于人类所做出的决策 。 与上述情况类似 , 鉴于当下人工智能在技术方面所存在的不稳健性 , 如自动驾驶所存在的隐患等 , 完全信任也同样不可取 。

杰夫·拉尔森(Jeff Larson)等人就曾对基于机器学习而进行累犯预测的软件——替代性制裁的惩罚性罪犯管理量表(Correctional Offender Management Profiling for Alternative Sanctions , 简称COMPAS)的有效性展开剖析 。[13]从COMPAS所做出的预测来看 , 黑人被告比白人被告更可能被错误地认为是成为累犯的风险更高 , 而白人被告比黑人被告则更有可能错误地标记为低风险的累犯 。 但事实上 , 关于黑人被告的累犯预测是高于现实的 , 而关于白人的累犯预测则是低于现实的 。 在未来两年中 , 白人被告累犯被误判为低风险的是黑人被告累犯的几乎两倍(48%比28%) 。[14]即 , 依据该软件所做出的预测 , 与现实并非完全吻合 , 因此 , 应当审慎地对待COMPAS输出的结果 。 但这种质疑事实上并非意味着对COMPAS的完全不信任 , 而是旨在探究怎样的人与技术信任才可以有效的方式确保人工智能向善 , 对人类不造成伤害 。

信任是一个动态的交互过程 。 就人与技术的合作而言 , 信任是人对技术心理的预期与技术自身的效能一种混合交互 。 就人际间信任而言 , 无监督的信任是其最高层级 , 是委托人对受托人的完全信任 。 但就人与技术的信任而言 , 恰恰需要的是有监督的信任 。 如果说传统意义上的人与技术之间的信任 , 可以逐步还原到人与人之间的信任 , 进而可以借助人际间的信任来确保人与技术之间的信任 。 但就人与人工智能系统而言 , 由于人工智能系统的能动性与自主性等所带来的某种不可解释性、不透明性、不可追溯性等 , 上述还原越来越难 , 因此 , 人与人工智能的合作必须基于有效监督的信任 。 但该如何用信任解码人工智能伦理呢?关于此的解答 , 首先需要从伦理学的视角来厘清人工智能信任的构成要素 。

三、人工智能信任的构成要素:基于伦理视角的解析

欧盟委员会从技术和伦理两个维度解析了何为“可信任人工智能”;IBM所提出的“Trusted AI”意味着值得信任是人类对人工智能技术所给予的期望 。 毫无疑问 , 可信任(信任度 , 值得信人)是信任的一种表征 , 是人工智能信任的一个重要维度 。 莫瑞奥萨瑞·塔迪欧(Mariarosaria Taddeo)曾指出:“信任和电子信任被以如下三种方式予以界定:(1)作为可信任性的一种盖然性的评估;(2)作为一种基于伦理规范的关系;(3)作为一种行动者的态度 。 ” [15]因此 , 就人工智能的信任而言 , 至少应与如下三个方面相关:与人相关 , 因为对人工智能的信任发端于人;与社会环境相关 。 良好的信任社会体系与信任社会制度将为人工智能的信任提供良好的存在语境;与技术相关 , 如技术过程(如算法的透明性与可靠性等)、技术目的、技术的性能与效应等诸如此类的技术要素 , 是人工智能信任的必备要素 。 因此 , 人工智能的信任应包括人、技术与环境等 。

从伦理学的视角来看 , 人工智能的信任首先需要构建的是人类对伦理学的信任 。 长期以来 , 在技术的发展历程中 , 伦理学主要基于外部的视角 , 以批判式的反思方式出场 , 因此 , 出现了伦理学被视为落后于技术发展的追思 。 近年来 , 伴随伦理学以进入技术内部的方式而开启伦理对技术的引领与规范功能时 , 负责任的创新、负责任的人工智能等词汇进入到了技术界 。 即便如何 , 在人工智能的伦理构建之中 , 技术界关于伦理的功能和效应也众说纷纭 。 其中 , 不乏对伦理的质疑 。 但若缺乏人类对伦理学的信任 , 则人工智能伦理构建的意义也有待商榷 。 因此 , 需要通过构建人类对伦理学的信任来夯实人工智能伦理的构建基础 , 进入以伦理促进人工智能能够谋求人类福祉 。

其次 , 构建人类对人工智能的信任 。 信任是一种信念 , 一种态度意向性 。 “不能建立信任 , 特别是最终用户的信任 , 惠及所有利益相关方的个人数据生态系统就将永远不会存在 。 ” [16]同样地 , 公众对人工智能的信任将为人工智能的发展提供有力的支撑 。 正是基于此 , 在美国的“国家人工智能研究和发展战略计划:2019更新版”中 , 明确指出:美国必须培养公众对人工智能技术的信任和信心 , 在技术的应用中 , 应保护公民自由、隐私和美国价值观 , 从而让美国人民充分意识到人工智能技术的潜力 。

再者 , 人工智能自身信任度的构建 , 即人工智能自身的可信任问题 。 人类对技术的信任 , 需要技术的性能作为其值得信任的背景 。 人工智能自身的技术信任度应当是人工智能发展的应有之义 。 纵观近年来关于人工智能发展的战略与规划 , 这一主题一直备受关注 。 关于此的阐述 , 从内容上看 , 包括关于人工智能信任的重要性、构建途径、评判标准等 。 如:在美国电子电气工程学会关于“伦理辅助性设计”中 , 将人工智能系统的透明性等视为构建用户对人工智能系统信任的一个重要关节点;欧盟委员会的《可信任人工智能的伦理框架》 , 将人类自治原则、避免伤害原则、公平原则、可解释性原则等作为构建人工智能可信度的基础原则 , 将人的能动性和监督能力、安全性、隐私数据管理、透明度、包容性、社会福祉、问责机制等视为可信任人工智能需要满足的条件;美国最新版的国家人工智能战略则进一步强调了发展人工智能信任度的重要性 , 并将确保人工智能系统的安全作为其战略之一 。

最后 , 构建人工智能系统中各个代理间的信任 。 在人工智能系统中 , 无论是关于一个问题的解决 , 还是关于一个整体目标的实现等 , 都需要各个代理之间的协作与合作 。 近年来 , 关于多代理系统(Multi-Agent System)的研究是人工智能研究的热点之一 , 特别是关于其体系结构和协调机制的研究是其核心研究论域 。 借鉴信任在人际之间的协作与合作中所具有的效用 , 同样 , 人工智能系统各个代理间的信任是人工智能信任的一个不可或缺的一部分 。 对其的构建是提升人工智能性能的一个有力保障 , 更是开启人工智能伦理构建的一把钥匙 。

文章图片

图1:人工智能信任的构成要素

图1所展现的四个构成要素 , 主要是基于人作为伦理主体的视角 , 从内部和外部两个方面展开的横向解读 。 其中 , 内部信任意指人类自身的信任问题 , 包括人类对伦理学的信任和人类对人工智能的信任;外部信任意指技术的信任 , 包括人工智能自身的信任度和人工智能系统中各个代理间的信任 , 且这些要素之间存在交集与交互 。

与此同时 , 基于伦理学的视角 , 关于信任的解读 , 还需要从纵向的维度来展开 , 因为信任同时也是一个动态的交互过程 。 从微观的视角来看 , 这种动态性表现为:上述四种信任各自的形成是动态的 , 且这四种信任彼此互相影响;从宏观的视角来看 , 这种动态性表现为在人工智能伦理原则与人工智能系统的之间的开放性、适应性与交互性中 , 信任被不断地建构 。 而这恰恰与人工智能系统发展的动态性相吻合 , 与伦理学应当是对技术发展的有效应对与前瞻性反思的主旨相契合 。 但这种动态性并非意指伦理对技术的让步 , 而是在坚守伦理基本原则基础上的动态调适 , 以及技术需要以合乎伦理的方式而发展 , 即 , 技术依据伦理基本原则而调整其发展 。

四、小结

尼克拉斯·卢曼(Niklas Luhmann)曾将信任视为社会生活的一个基本方面 , 认为:信任的缺席甚至将阻止他或她早晨起床 ,[17]同样地 , 过渡的信任、错误的信任与盲目的信任也将带来风险 。 在不久的将来 , 人工智能将是我们社会生活的一个基本方面 , 人工智能的缺席将使得人类日常生活的运作遭遇困境 。 同理 , 人工智能的过渡泛滥与盲目增长也将使得人类日常生活的运作遭遇困境 。 人工智能伦理的缺席将使得人类的尊严恰恰正是由人工智能的发展而遭遇挑战 , 人类的福祉也恰恰是因此而得不到保障;同理 , 无效的或不当的人工智能伦理也会造就上述结果 。

面对智能时代的到来 , 借助信任 , 调节人与人工智能的合作关系 , 助推人类社会的发展 。 从人类对伦理学的信任、人类对人工智能的信任、人工智能自身的信任度、人工智能系统中各个代理间的信任等四个方面开启人工智能伦理的构建 。 但这种信任如奥诺拉·奥尼尔(Onora Sylvia O'Neill)所言:我们所期望的 , 并不是像小孩一样盲目地去信任 , 而是要有良好的判断能力 。 为了判断别人说的话 , 做的事是否值得信任 , 我们需要有足够的讯息和辨别的手段 。 为了做到合理的信任 , 我们不仅需要辨别出哪些说法或行为值得去信任 , 也需要去思考关于它们的合理性 。[18]因此 , 以有效监督的信任为前提 , 审视人与人工智能的合作 , 以合势的人工智能伦理 , 为人工智能的发展塑造理性的氛围 , 进而化解人工智能的不确定性 , 夯实智能社会的基本架构 , 确保人工智能向善 。

[1] Will Knight .Google appoints an “AI council” to head off controversy, but it proves controversial [EB/OL]. https://www.technologyreview.com/s/613203/google-appoints-an-ai-council-to-head-off-controversy-but-it-proves-controversial /.

[2] Will Knight.Google employees are lining up to trash Google’s AI ethics council [EB/OL]. https://www.technologyreview.com/s/613253/googles-ai-council-faces-blowback-over-a-conservative-member/.

[3] Nobert Wiener.Some Moral and Technical Consequences of Automation. Science, 1960:131(3410):1355-1358.

[4] Arthur L.Samuel.Some Moral and Technical Consequences of Automation—A Refutation. Science, 1960:132(3429), 741–742.

[5] https://www.research.ibm.com/artificial-intelligence/trusted-ai/.

[6] IEEE. Ethically Aligned Design: A Vision for Prioritizing Human Well-being with Autonomous and Intelligent Systems, First Edition[EB/OL]. https://ethicsinaction.ieee.org/.

[7] 国务院.新一代人工智能发展规划[EB/OL].http://www.gov.cn/zhengce/content/2017-07/20/content_5211996.htm.

[8] European Commission. Draft Ethics Guidelines for Trustworthy [EB/OL].https://ec.europa.eu/digital-single-market/en/news/draft-ethics-guidelines-trustworthy-ai.

[9] Andrea Renda.Artificial Intelligence: Ethics, governance and policy challenges[EB/OL] .https://www.ceps.eu/system/files/AI_TFR.pdf.

[10] National Science &Technology Council. The National AI R&D Strategic Plan: 2019 Update[EB/OL] .https://www.nitrd.gov/pubs/National-AI-RD-Strategy-2019.pdf.

[11] 国家新一代人工智能治理专业委员会:新一代人工智能治理原则——发展负责任的人工智能[EB/OL]. http://www.most.gov.cn/kjbgz/201906/t20190617_147107.htm

[12] [美] 皮埃罗·斯加鲁菲(Piero Scaruffi).智能的本质:人工智能与机器人领域的64个大问题[M]. 任莉 , 张建宇 译.北京:人民邮电出版社 , 2017:168.

[13] Jeff Larson, Surya Mattu, Lauren Kirchner and Julia Angwin.How We Analyzed the COMPAS Recidivism Algorithm[EB/OL].https://www.propublica.org/article/how-we-analyzed-the-compas-recidivism-algorithm.

[14] Jeff Larson, Surya Mattu, Lauren Kirchner and Julia Angwin.How We Analyzed the COMPAS Recidivism Algorithm[EB/OL].https://www.propublica.org/article/how-we-analyzed-the-compas-recidivism-algorithm.

[15] Mariarosaria Taddeo . Defining Trust and E-trust: From Old Theories to New Problems[EB/OL]. https://www.academia.edu/1505535/.

[16] 托马斯·哈乔诺 , 大卫·舍瑞尔 , 阿莱克斯·彭特兰.信任与数据:身份与数据共享的创新框架[M].陈浩 译.北京:经济科学出版社.2018:139.

[17] Niklas Luhmann. Trust and Power [M]. Cambridge: Polity Press. 2017:5.

[18] 奥妮尔(O'Neill, Onora), 信任的力量[M].闫欣 译.重庆:重庆出版社 2017:60.

原载于《人工智能》2019年第4期 。

(本文来自澎湃新闻 , 更多原创资讯请下载“澎湃新闻”APP)

推荐阅读

- 产品|泰晶科技与紫光展锐联合实验室揭牌

- 空间|(科技)科普:詹姆斯·韦布空间望远镜——探索宇宙历史的“深空巨镜”

- 相关|科思科技:无人机地面控制站相关设备产品开始逐步发力

- 机身重量|黑科技眼控对焦23年后回归,升级! 江一白解读EOS R3

- 公司|科思科技:正在加速推进智能无线电基带处理芯片的研发

- 项目|常德市二中2021青少年科技创新大赛再获佳绩

- 视点·观察|科技巨头纷纷发力元宇宙:这是否是所有人的未来?

- 技术|聚光科技旗下临床质谱仪获批医疗器械注册证

- 人物|造车三兄弟的“喜与忧”:销量暴增但问题加剧,一人舒服两人困难?

- 视点·观察|科技股连年上涨势头难以持续:或已透支未来涨幅