文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

我对两年前小鹏汽车的第二届 1024 汽车科技日 , 印象实在是太深刻了 。 那年发布会的两个重点 , 无论高速场景的 NGP 导航辅助驾驶 , 还是可见即可说的全场景语音 , 放在 2020 年这个时间节点 , 几乎找不到对标的产品 。

相对而言 , 今年 1024“激动人心”的程度似乎不比前两年 。 我想 , 一方面是因为最近两年汽车领域进步太快 , 在各种智能化领域大家都迅速追上来了;另一方面 , 小鹏自己也没有把重心 , 太多地放在那些“惊艳”的部分 。 今年的汽车科技日 , 小鹏的重点似乎转到了“如何实现过去的惊艳”上 。

整场发布会的大部分时间 , 都用在高级辅助驾驶上 。 去年 , 小鹏在汽车科技日带来了城市场景的 NGP 导航辅助驾驶功能 , 这些功能上个月已经推送给配备激光雷达的 P5 用户 。 随着广州、深圳成为第一批开放城区辅助驾驶高精地图的城市 , P5 用户在相关区域就可以使用第一版城市 NGP 功能 。

根据小鹏的统计 , 城市道路在所有小鹏用户的行驶里程中占 71% , 时长则占了 90% , 毫无疑问是高频场景 。 当然 , 要实现它的难度也很高 , 城市 NGP 的代码量是高速 NGP 的 6 倍 , 系统需要录入 4 倍的感知模型才能应付 , 而预测和规控的代码数量则是高速 NGP 的 88 倍 , 差不多两个数量级 。 简而言之 , 在城市实现导航辅助驾驶 , 系统要看得懂更多东西 , 也要有更多的自主决策能力 。

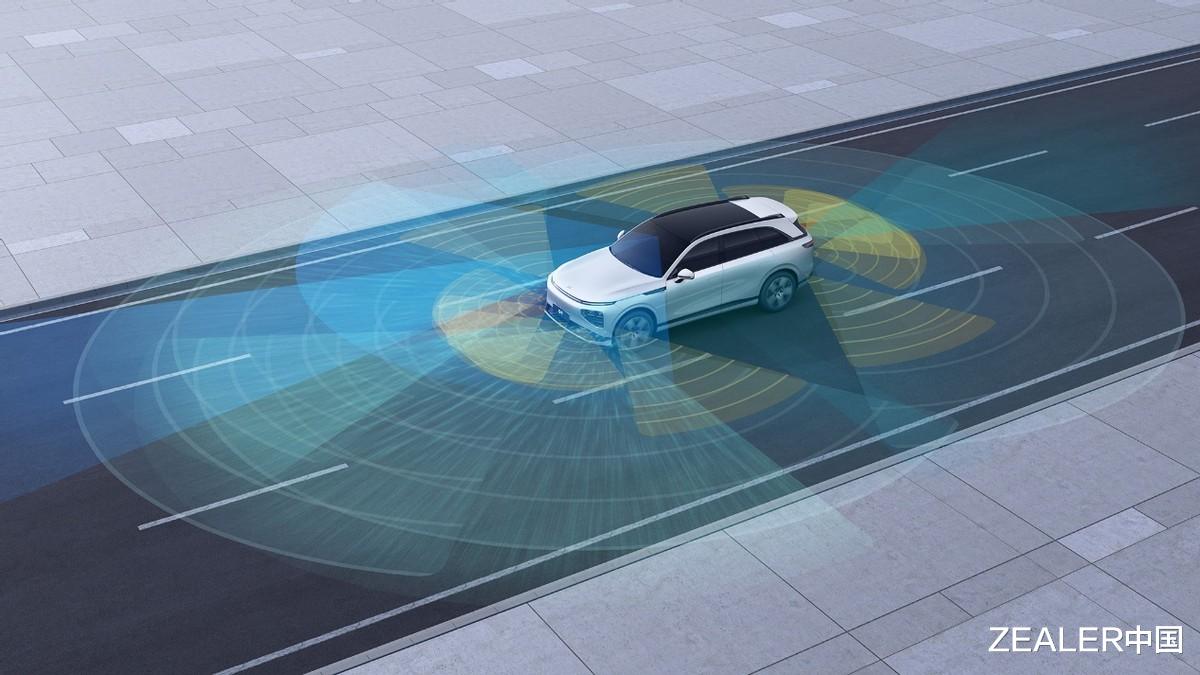

小鹏在这里的解决方案还是相对比较常规的:通过多传感器融合 , 以及经过初步训练 , 更接近“老司机”的行为模式 , 让 P5 在覆盖有高精地图的区域实现辅助驾驶 。 至于遇到没有高精地图的场景 , 小鹏仍会充分利用感知能力 , 使用 LCC-L 等降级功能保证安全可用 。

今年实现城市辅助驾驶验证开放后 , 小鹏从 2023 年起 , 就要开始推进多个场景无缝融合的全场景辅助驾驶了 , 并且要在 2025 年后往无人驾驶的方向发展 。 整体目标也很明确 , 就是要在没有高精地图的支持下连接停车场、城市、高速三大场景 , 全程尽量 0 接管 , 并做到超越人类驾驶员的博弈、通行效率和安全性 。 这套辅助驾驶系统被小鹏称为 XNGP 。

XNGP 仰赖的硬件基础没我们想象得那么遥不可及 , 在 G9 上面我们都见过了:分布全车的高精度摄像头 , 前向两个激光雷达 , 全车 5 个毫米波雷达以及 508TOPS、包含两个英伟达 Orin 芯片的计算平台 。 没有在显而易见的硬件上继续“卷”下去 , 可能让一些朋友觉得无聊 , 别担心 , XNGP 有意思的地方在于软件和算法 。

为了实现 XNGP , 小鹏也开始对感知架构进行调整 , 新的感知架构名为 XNet 。 从前的 NGP 会使用比较传统的单一摄像头、单一图像帧处理方案 , 两个摄像头之间、上一帧与下一帧之间没有关联性 , 就像我们“眨眼补帧”一样;如果再不加上前后画面的关联 , 那整个感知架构就和看幻灯片没区别 。

在 XNet 架构中 , “幻灯片”变成了“长视频” 。 通过引入 Transformer 机器学习架构 , 融合多个摄像头的数据 , XNet 不止可以生成实时感知周围车辆、环境的鸟瞰图(也就是大 V 们三句话不离的“BEV” , Bird’s Eye View , 实际相当于类似全景影像视图的“上帝视角”) , 还能通过“特征金字塔”(简称 FPN)预测周围道路使用者接下来大概率会走的轨迹 , 为接下来决策“自己该怎么走”提供数据基础 。

推荐阅读

- 奥多姆坦言湖人该交易浓眉:若因伤不能上场 科比也会同意交易他

- 浙江台州温岭,一女子的车钥匙被抢走了,车子被人开跑!

- 索尼第一台车,居然不能索尼大法好?

- 51岁港星定居东莞,深夜光顾路边摊接地气

- 最新侧面碰撞结果公布,福特电马获得G最佳安全评价

- 驾车时看到绿灯只有一秒了,于是就缓速停下来等待结果被追尾了,事故该如何定责?

- 突然发现,疫情反复无常3年,大家反而变轻松了

- 枪杀现场:史上最淡定的仨大爷!