制图:冯婧

围绕人脸识别技术有诸多讨论:它的识别准确性如何?数据会“歧视”哪些群体?作为敏感信息 , “人脸”是如何存储的?使用后 , 数据会被销毁吗?

经过六十年的发展 , 它不再是加州一间小办公室里技术探索者的古怪实验 , 人们试图去理解 , “黑箱”里有什么 。

“越来越多人开始关注 , 算法如何利用我的数据来定义我 , 它将如何影响政府和商家 , 他们会以此做出哪些关于我的决定” , 长期关注数据法的研究者安巴·卡克(Amba Kak)在接受澎湃新闻(www.thepaper.cn)专访时这样表示 。

卡克是纽约大学AI Now研究中心的全球战略及项目总监 , 今年9月 , 他们发布了一份 报告 , 梳理全球范围内人脸识别技术引发的争议 , 并评估了现有数据保护法及相关条例的效力 , 报告提出 , 仍有诸多问题未能得到有效回应 , 即便是被称为“史上最严格数据保护法”的欧盟《通用数据保护条例》(GDPR) 。

澎湃新闻:谈谈这份报告的缘起吧 。

安巴·卡克:差不多一年前 , 我们启动了这个项目 。 当时我们能感受到 , 世界范围内 , 围绕生物识别——特别是人脸识别 , 各种讨论达到了高峰 。 热度既来自这项技术的大规模应用 , 也暗含人们对它的担忧 。 人们期待 , 能有更针对性的法律规范这项技术 。

实际上 , 全世界范围内 , 大约有130个国家拥有数据保护法 , 它们都涵盖了生物特征数据 , 一些地区有更针对性的法律 , 比如美国伊利诺伊州的《生物识别信息隐私法》(BIPA)、欧盟的《通用数据保护条例》(GDPR) 。 但深入研究 , 这些法律条文仍有局限 , 比如 , 它们仍然无法有效解决人脸识别技术的准确性、数据歧视等问题 。

这份报告收录了8个来自世界不同地区的案例 , 我们希望梳理目前生物识别技术在应用中的诸多困境 。

澎湃新闻:人们对于人脸识别技术的担忧似乎存在一些地区差异 , 比如 , 美国的研究和行动者聚焦在种族歧视问题 , 人脸识别技术对于少数族裔的误识率很高 , 当它应用于警察执法会造成偏误 。 而中国更关注数据隐私和安全性等问题 。

安巴·卡克:确实有差异 , 但我认为 , 其中存在共性 。

先谈“歧视” , 很有趣的一点 , 谈及这个词 , 很多人第一反应是种族 , 特别是美国 , 如你所说 , 目前很多研究都集中在这一领域 , 它确实引发了一些误捕事件 , 所以才有了之后许多城市的禁令 , 警察执法不得使用这项技术 。

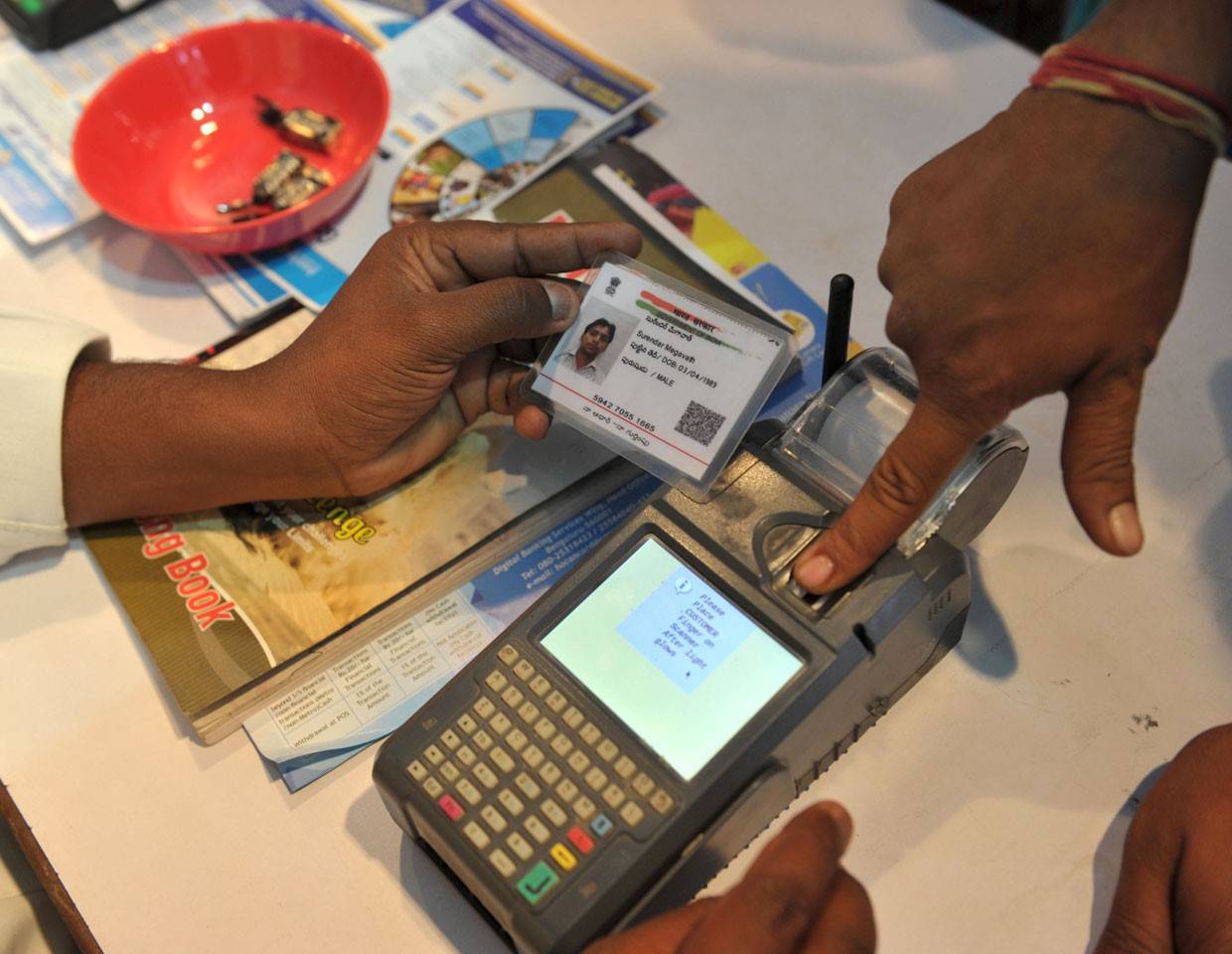

但“歧视”还会涉及更多群体 , 比如女性、老年人 。 举个例子 , 我来自印度 , 2009年印度政府启动了Aadhaar项目 , 计划为11亿人口建立一个生物特征数据库 , 每个公民的指纹、虹膜 , 甚至人脸信息都将纳入其中 , 作为公民身份的唯一标识符 (编者注:identifier , 指用来标识某个实体的一个符号 , 来源于计算机编程语言) , 与教育、医疗、保险、金融等社会生活的方方面面绑定 。

Aadhaar的初衷之一是为了减少社会福利的冒领、漏洞 , 减少中间环节 , 避免因官员腐败 , 救济无法到达需要的人手中 。 但很快人们发现了各种问题 。 许多底层劳动者由于长期劳作 , 指纹严重磨损 , 难以被识别 , 无法获得救济 。

Aadhaar打造了一套唯一身份系统 , 但这些群体却被排斥在外 。 除此之外 , Aadhaar计划还有很多问题 , 比如数据安全 , 我们的报告中也有一章专门讲Aadhaar计划 。

或许相较于“歧视” , 更准确的词是“排斥”(exclusion) , 如果你生活在一个人口结构并不那么多元的社会 , 种族歧视似乎离你较远 , 不如想想排斥 , 你是否被某种系统排斥在外了 。

文章图片

Aadhaar计划建立了一套生物特征数据库 。 图片来源:Getty

澎湃新闻:比如数字鸿沟也会造成排斥?新冠疫情期间 , 中国的“健康码”发挥了很大作用 , 但对于一些不习惯使用智能设备的群体 , 他们的生活也遇到了障碍 。

安巴·卡克:没错 。 几乎每个地区都有数字鸿沟 , 可能是某些地区的网络覆盖率有限 , 也可能是某个人群不习惯使用智能设备 。

Aadhaar使用唯一识别码(UIDAI)与社会福利绑定 , 可以追问两个问题 , 涉及到社会福利领取这种社会基础服务时 , 是否可以保留其他“低技”的、非数字化的方式?技术的初衷是为了提高效率 , 但对于某些群体而言 , 它恰恰起到了相反作用 。 另一个问题是 , 当个人对识别结果存疑时 , 是否有申辩机制?

澎湃新闻:人脸识别的准确性引发了各种讨论 , 技术供应商往往宣称很高的准确性 , 但一些独立测评显示 , 对于某些群体误识率更高 , 可以对准确性提出“行业标准”吗?报告中提到了一点 , 立法者开始意识到需要对技术供应商进行审查 , 如美国国家标准技术研究院(NIST)会设置基准 , 他们有自己的数据集 , 可以进行独立测试 。

安巴·卡克:是的 , 比如NIST的 “2019人脸识别供应商测试”(Face Recognition Vendor Test , FRVT) , 它会评估同一个算法对于不同人群的表现 。

值得注意的是 , 这套标准可能只适用于美国独特的社会人口结构 , 比如种族、年龄、性别等等 。 如果在亚洲、拉美地区 , 数据集和标准可能完全不同 。

设置准入标准是正确的方向 , 允许专业机构对准确性进行评估 。 但目前 , 包括NIST等标准设置机构在内 , 他们提出的标准具有多大效力 , 学界也有不同意见 。 有研究者发现 , 一些已经通过了标准测试的算法 , 在实操环节仍然低于预期 。

文章图片

2018年底 , 伦敦警方曾使用安装有摄像头的面包车来监视街道安全 , 这在当时引发民众抗议 。 图片来源:视觉中国

澎湃新闻:2019年旧金山提出人脸识别禁令后 , 多个城市纷纷通过了类似的禁用措施 , 主要禁用范围是警察执法 。 最近波特兰也提出 , 禁止私人公司在公共场所使用这项技术 。 有人担心 , 一刀切式的禁止是一种“技术恐惧论” 。

安巴·卡克:这个问题非常有趣 。

首先 , 媒体报道中使用了一个非常干脆的词 , “禁令”(Ban) , 但许多城市出台的是类似“暂停令”(Moratorium) , 暂时叫停这项技术的应用 , 直到有更深入的研究 , 或更健全的法律 , 可以切实保障个人权利 。

这一轮人脸识别禁用浪潮可能会造成一种印象——这是一个糟糕的技术 , 但我认为 , 恐惧论会让人们远离它 , 而非了解它 。

这一轮禁令浪潮背后有很多讨论会 , 有的由城市的市政部门组织 , 有的由公民团体组织 。 很多人试图去理解“黑箱”里运行的技术——算法如何利用我的数据来定义我 , 并做出关于我的决定 。

举个例子 , 我们正在研究新冠疫情期间 , 全球的各种防疫软件 。 中国有健康码 , 用不同颜色区分你的安全级别 , 据我了解 , 持有绿码者可以通行无阻 , 而红码就无法进入某些地方 。 人们会关心颜色为何发生变化 , 如果它对我的判断有误 , 我能否挑战它 , 为自己申辩?

类似的讨论在全球各处都能看到 , 越来越多 , 透明度和申辩机制都很重要 。 所以我并不赞同技术恐惧论 , 相反应该鼓励人们“打开”黑箱 。

澎湃新闻:目前 , 世界范围内 , 很多数据保护法都强调了“同意”的重要性 , 但这份报告似乎持有不同观点 , 为什么?

安巴·卡克:是的 , 同意并不重要 , 或者说 , 它并不如你想象中那么重要 。

个人需要有知情权 , 了解数据具体的使用场景、使用目的 , 如何获取、存储、处理、销毁 。 但“同意”并不等于你真的有选择权 。

现有的“同意”机制存在问题 , 比如 , 当你想要安装一个App , 手机会弹出的说明框 , 你可以选择同意 , 但如果不同意就意味着你无法使用这个App 。 不要对“同意”有什么浪漫化的想象 , 它不能保护我们的权益 , 相反 , 它可能会被恶意曲解为一种“授权” 。

无论从技术还是法律的专业背景上 , 个人与科技公司都是不对等的 , 保护个人信息安全不该是个人的责任 , 而应是政府的职责 。 所以相较于一个模糊而形式化的“同意” , 政府需要更明确的法规 , 规定数据的获取及使用 。

文章图片

人脸可以作为一种连接个体信息的标识符 , 与消费习惯、行踪轨迹等互通 。 图片来源:Flickr

澎湃新闻:最近 , 中国公布了《个人信息保护法(草案)》 , 并向社会征询意见 。 有法律学者提及 , 需要限定人脸识别技术的使用目的 , 它应该被应用于身份验证 , 而非其他商业性目的 , 比如用户画像和精准营销 。 《欧盟通用数据保护条例》等法规中也提出了一些原则 , 比如“必要性原则”、“使用目的限定原则” , 实际操作中 , 这些原则的效力如何?

安巴·卡克:可以拆分成两个问题 。

首先要警惕一种简化的对比 , 认为“识别”(Identification)是高风险的 , 而身份“验证”(Verification)是100%安全的 , 但就像我前面提到的那些因素 , Aadhaar就是一种身份验证 , 但很多人无法识别指纹 。

使用目的限定原则(Purpose-limitation Principle)非常重要 。 比如 , 我可以将我的个人数据放心交给住房委员会 , 因为我清楚他们会如何使用我的数据 。 但如果数据泄露 , 或是被卖给了保险公司 , 他们可能会对我做出判断 , 比如拒绝为我贷款 。

这个设想很好 , 但在执行层面上看存在困难 。 如Google这样的科技巨头 , 业务涵盖多个领域 , 彼此之间会不会进行数据互通?比如 , 我的健康数据会不会分享给保险公司 , 或者广告精准营销?所以实际操作层面 , 立法者、公民团体或许需要做更多实践 。

澎湃新闻:报告中提到了一个有趣的案例 , 国际红十字会在分配人道主义救援时使用了生物识别技术 , 但他们决定放弃建立一个中心化的生物特征数据库 。 中心化的数据库存在哪些风险?

安巴·卡克:新冠疫情期间 , 你能看到中心化的数据库 , 针对防疫它很有效 。 但它又存在风险性 。 一是数据安全 , 当所有敏感信息都存储在一个中心化的服务器上 , 如果遭到攻击 , 很容易危及整个数据库 。

第二层风险 , 我们称之为“蜂蜜罐”(honeypot) , 它与前面提到的“使用目的限定原则”存在冲突——将不同来源的数据整合 , 这件事情诱惑太大了 。

这也是红十字会案例中 , 人们的担忧:他们有必要使用生物识别技术 , 以提升发放救援物资的效率 。 但试想 , 如果你拥有一个关于难民的中心化的生物特征数据库 , 会有太多力量想要访问这些数据 。 所以红十字会通过技术手段 , 尽量减少生物识别技术的实际保留 。

澎湃新闻:报告的最后一章提到了一个案例 , 纽约的一处公立学校 , 家长们反对校方以安保为名使用人脸识别技术 。 针对这项技术的应用伦理 , 社区在其中可以起到什么样的作用?

安巴·卡克:我们想通过这个案例告诉大家 , 行动是可能的 。

这个案例中 , 家长们讨论的都是最具体的问题 , 而不再是一些看起来时髦却有些抽象的词汇 , 比如隐私和监控 。 孩子的日常生活会面临哪些改变 , 是否有其他更好的方式使用这笔资金 。

实际上 , 在全球关于人脸识别的讨论中 , 我们能看到这种转向 , 从抽象的概念走向具体的问题 。

再谈谈印度 。 进行国际比较时 , 我们发现 , 很难在当地语言中找到一个词汇来表达“隐私” , 这个词当然是存在的 , 只是人们在日常生活中很少会用到它 。 当你去问一个普通印度人 , “人脸识别摄像头会侵犯你的隐私吗” , 或许他无法明白你在说什么 。

这份报告发布后 , 很多人会问我 , “你对我们国家的生物识别技术法律有什么建议吗?”这个问题太大了 , 不如看看周围 , 如就业、居住、子女教育 , 人脸识别技术对你的生活产生了哪些影响?你同意它对你的判断和决策吗?

(市政厅得到AI Now授权 , 近期将翻译报告中的部分内容 , 呈现不同城市的行动与思考 。 )

【数据|人脸识别60年︱安巴·卡克:行动者们正在打开“黑箱”】(本文来自澎湃新闻 , 更多原创资讯请下载“澎湃新闻”APP)

推荐阅读

- 区块|面向2030:影响数据存储产业的十大应用(下):新兴应用

- 选型|数据架构选型必读:2021上半年数据库产品技术解析

- 殊荣|蝉联殊荣!数梦工场荣获DAMA2021数据治理三项大奖

- 数据|数智安防时代 东芝硬盘助力智慧安防新赛道

- 识别|沈阳地铁重大变化!能摘口罩吗?

- 识别|天津滨海机场RFID行李全流程跟踪系统完成建设 行李标签识别成功率可提升至99%

- 平台|数梦工场助力北京市中小企业公共服务平台用数据驱动业务创新

- 数据|中标 | 数梦工场以数字新动能助力科技优鄂

- 建设|数据赋能业务,数梦工场助力湖北省智慧应急“十四五”开局

- 市民|大数据、人工智能带来城市新变化 科技赋能深化文明成效