本文旨在向读者指出通用性AI发展面临的许多挑战和误解 。 短期应用成果应与长远蓝图相得益彰 。 我们需要渊思寂虑 , 精进系统研发 , 从而理解主体感知 , 并使之实时适应不断变化的环境 。

撰文 | Patrick Hammer(Temple University , USA), Tony Lofthouse(Evolving Solutions Ltd., UK)

翻译 | 刘凯(渤海大学教育科学学院、渤海大学通用人工智能研究所)

能记忆和推理不同情境信息的个人AI助手总似“呼之欲出” , 但直至鼠年年末 , 这样的AI助手竟仍未实现 。 同样 , 机器学习尽管进展斐然 , 可一旦离开“人工”协助 , 自主系统依旧难言“智能”——无法在不同学习中贯通数据并整合模型 , 以实现经验的跨领域迁移 。

若将AI的目标设定为优化函数来解决领域问题 , 那么我们一直在与日俱进 。 很多曾被视作难如登天的特定问题(参考文献[1][6][11]) , 用最优化——尤其是深度神经元网络(DL)的反向传播来解决 , 已被证实立见成效 , 且远超人力之际 。 计算机视觉、机器翻译、语音识别、棋艺博弈、电子竞技等诸多领域焕然如新——人工智能正迅速被全面“驯化” 。

正所谓“莫为风波羡平地 , 人间处处是危机” , 此类“驯化”的共同缺陷是:学习仅发生在模型部署之前 。 可事实上 , 实时学习才是动物获得生存优势的智能展现 。 相较而言 , 支撑机器学习的脊檩则是狭隘的学习理念 。 更深入地看 , 所有的离线优化(Offline Optimization)问题 , 本质上都是基于进化而非个体智慧 。 例如 , 假定被植入某种遗传密码 , 转基因萤火虫就能准确探测特定猎物并成功捕食 。 这种情况下 , 萤火虫无需实时学习便可拥有相应技能 。 类似地 , 只要预装导航、定位、目标检测(Object Detection)等预置功能的模块或经离线优化设定参数 , 自动驾驶汽车就应该能够即开即走 。

时至今日 , 如何从离线优化转向快速可靠的实时学习 , 主流人工智能仍未给出令人信服的回答 。 但这既是对智能本质之叩问 , 也是人工智能的初心所向 。 与荒野生存的动物一样 , 通用人工智能(Artificial general intelligence , AGI)能够在运行时应对无法预见的情况 。 快速和可靠的适应力不仅能够推动新一代机器人及个人助手的实践发展 , 也理应被视为智能理论的那块“核心拼图” 。

对“智能”一词的理解万别千差、百口不一 , 王培为此专门撰写《人工智能定义专论》一文 , 并刊发于《通用人工智能》(JGAI , 2019年第10卷) 。 这篇文章被认为是解决人工智能领域核心历史遗留争议最给力的尝试之一 , 受邀的同行评议专家多达110位 , 且广泛来自多所著名大学以及DeepMind、Google Brain等知名业界公司 。 文章标靶为智能的“非主流”定义 , 即“智能是知识和资源不足情况下 , 主体对环境的适应能力” 。 尽管该定义在另一项对567名人工智能专家的调研中高票获选 , 但对资源限制和实时适应必要性的质疑之声也同样存在 。 有些质疑源自人工系统与生物系统的差异 , 认为后者总是在知识和资源不足的条件下通过演化进行适应 , 但部署后的AI系统则无需再配备这种能力 。

对智能本质的不少误解都为忽视实时学习所致 。 比如 , 遗传算法(GA , 参考文献[5])有时被当做强化学习(RL , 参考文献[12])的“替身” 。 诚然 , 根据前文所述 , 遗传算法之于强化学习 , 正如进化之于智能 。 但只有当学习发生在海量的代际实例模拟中 , 上述类比方才成立 。 而这对自主机器人或动物毫不适用 , 因为二者都能在单次生命周期内以最快速度适应未知环境 。 很显然 , 只要致命事件发生一次 , 个体学习也就戛然而止 。 这也正是高度模拟领域(如参考文献[11])取得了巨大成功却难以“变现”的主要原因 。 于是 , 与实时的适应性系统相比 , 离线优化这位“同学”着实有些志大材疏 。

机器学习视角下 , 存在三项重要挑战:

一是 , 智能主体若想适应动态(非稳态)环境 , “好用”的决策理论便不可或缺 。 对动物而言 , 这是通过进化实现的 。 但对机器而言 , 单独个体的一生中却无法学到 。 因此 , 尽管离不开先天预设 , 但其行为表现则是先天和后天的相互结合 。

强化学习就是一个非常成功的决策理论(RL , 参考文献[12]) 。 虽在非稳态环境中难堪大用(主体的适应性需求与学习速率衰减是一对矛盾) , 不过至少能够用于实时学习 。 强化学习有一些主要概念的限制 , 基于行为主义的强化学习最为常见 。 通过对具有最高预期回报的“状态—行为”之间的响应映射(策略)进行学习 , 且无须对所在情境的其他因果关系进行建模 , 令此类主体具有奖励中心主义的世界观 。 这意味着 , 一旦效用函数发生变化 , 主体就必须重新习得一个新策略 , 既有知识也无法借助先天设计而迁移到新任务中 。 对于存在单一明确取胜标准的电脑游戏来说(如:赛车游戏中的圈速、象棋中的将军等) , 效用函数的变化不是问题 。 但对于生物系统而言 , 这却是日常的现实考量 。

动物在饿与渴的时候行为完全不同 , 前者会寻找猎物或美味的枝叶 , 后者会寻觅水源 。 也就是说 , 个体行为不仅取决于外部因素 , 也取决于内部需求 。 当出现特定需求时 , 个体寻求“因果知识” , 这一知识会自动迁移到解决下一次其他需求 。 如此 , 便能对不断变化的需求予以及时响应 。 但是 , 个体并不总能预先知道该如何满足特定需求 。 要解决这一问题 , 可将具体信念与动机系统解耦 , 令主体在不同的环境中学习到行为的不同结果 , 建立不同的因果模型 。 这是那些抱持AI初衷的AGI研究者所追求之路 , 但在专用人工智能(Special-purpose AI , SAI)领域中却常常无人问津 。

二是测量 。 毋庸置疑 , 不测量便无从知晓是否有进步 , 但测量的对象也很重要 。 我们在每个领域下测试主体表现 , 如果允许对不同领域设定不同的超参数(译者注:在机器学习中 , 模型“自学”得到的是参数 , 无法“自学”必须由“上帝”赋予的是超参数 。 深度学习“炼丹师”的一项重要操作就是对超参数的调校) , 得到的将是不同主体的“专项成绩” 。 虽在应用层面上十分有用 , 却对了解个体的一般性顿口无言 。 另一方面 , 如果因领域各异而设定不同超参数不被允许 , 那么得到的则是主体“各科考试”的“总成绩” 。

目前 , 最好的通用系统仍无法与专用系统(其超参数针可对特定目标领域进行调整)相媲美 , 但最好的专用系统其通用性得分却不会很高 。 类似情形在自然界比比皆是(如图1所示) , 尽管在特定静态环境 , 特定的专用方案往往是首选 , 但通用性却能使适应特殊环境条件变得更为容易 。

图1:高专用性的昆虫与高通用性的昆虫

从上述讨论中可以窥见:

衡量AGI成功与否需要改变已有的评估方式 。 AGI亦非AI超集 , 特定领域内大发神威的专用化最优方案 , 很可能在其他领域百无一用 。 在通向AGI的道路上 , 尽管并非总是 , 但一般情况下确与专用能力交集寥寥 。

写作此文正是想向读者指出通用性AI发展面临的许多挑战和误解 。 短期应用成果应与长远蓝图相得益彰 。 我们需要渊思寂虑 , 精进系统研发 , 从而理解主体感知 , 并使之实时适应不断变化的环境 。

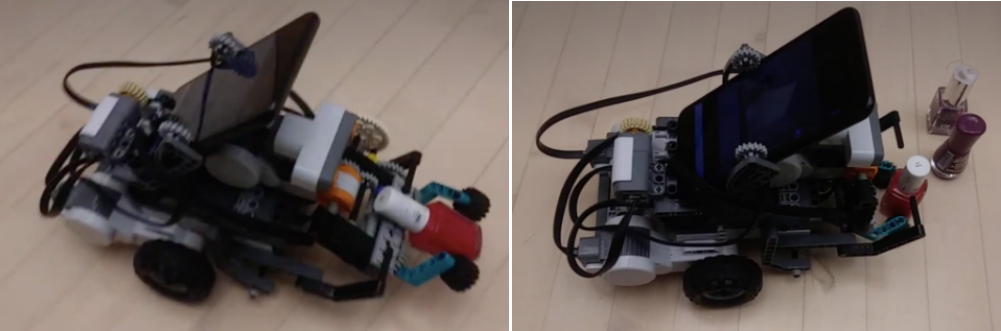

三是系统实现 。 非知之艰 , 行之惟艰 。 打造具有通用能力的系统实属不易 , 我们只是在漫漫前行路上迈出了一小步 。 王培提出的非公理逻辑推理系统NARS(Non-Axiomatic Reasoning System)[9]便是其中重要一例 。 NARS项目历经30余年 , 在实时学习、推理和目标满足等关键领域成效斐然 。 系统能通过自身感知对环境进行建模 , 适应环境 , 通过推理来决定下一步行动 , 从而实现自我目标 。 近期的研究亮点是 , 将深度神经网络(YOLOv4 , 参考文献[1][6])的视觉感知与NARS实时学习和推理能力(OpenNARS for Applications , 参考文献[4][13])进行整合 , 很好地完成机器人瓶子收集的任务(如视频所示) 。

机器人寻找瓶子、机器人抓住瓶子

机器人举起瓶子、机器人运送瓶子

图2:体现NARS实时推理与学习能力的瓶子收集任务

图注:此例虽小 , 但意义重大 。 首先 , 再次印证同一个通用人工智能系统能够完成不同的专用任务 , 而无需再次开发或修改源码重新编译;其次 , 明确说明通用人工智能系统的多种感知与运动功能能够在“大脑”的指挥下被妥善协调 , 而对算力仅有“微弱”的要求;最后 , 尽管单项能力非其所长 , 但对开放世界里又“找”又“避”又“抓”又“举”的“多强全能”冠军而言 , 通用人工智能系统必定是最有力的竞争者 , 没有之一 。

视频演示:[瓶子收集任务] [抓、举动作更替] , 可前往“返朴”观看 。

在这一任务中 , 机器人不仅需要协调视觉搜索和机械操作等多种感知运动功能 , 同时还要学习探索如何避障 。 这让NARS实时学习和实用推理相得益彰 , 二者融合一目了然——既能够充分体现实时学习的能力(常被视为强化学习的优势) , 又不失目标规划及利用背景知识的认知灵活性 。 而且 , 通过集成最新的深度学习模型来处理其所擅长的目标检测任务 , 可将机器学习的离线优化特点与AGI系统的实时学习和推理优势相互结合 , 此为SAI与AGI系统的共生之道 。 我们的AGI方案有望实现智能系统自主性的极大提升 , 并用于:

救援机器人探险机器人基于智能手机或PC的个人助手

无论是某种新型自主代理还是其他项目 , AGI的应用不拘形迹——“一切皆有可能” 。 一言以蔽之 , 实时学习乃AGI关键之法 , 离线优化的人工智能技术可以成为服务AGI“大脑”的其他延展“器官” , 从而令多模态学习及跨域迁移的交结变为现实 。 这样的系统具备真正意义上的智能 , 能迅速适应多变的现实环境 。

最后 , 总结本文要点如下:

AGI与SAI根本目标各异——通用VS专用AGI与SAI评价方式完全不同实时适应性是智能系统的必然要求NARS所依据的通用推理系统是实现真正智能的一种方法AGI时代的大幕正徐徐升起 。 2021 , 你好牛年 , 你好牛·年!

参考文献

[1] Bochkovskiy, A., Wang, C. Y., & Liao, H. Y. M. (2020). YOLOv4: Optimal Speed and Accuracy of Object Detection. arXiv preprint arXiv:2004.10934.

[2] Bratman, M. E. (1987). Intention, Plans, and Practical Reason. CSLI Publications. ISBN 1-57586-192-5.

[3] Georgeff, M., Pell, B., Pollack, M., Tambe, M., & Wooldridge, M. (1998, July). The belief-desire-intention model of agency. In International workshop on agent theories, architectures, and languages (pp. 1-10). Springer, Berlin, Heidelberg.

[4] Hammer, P., & Lofthouse, T. (2020, September). ‘OpenNARS for Applications’: Architecture and Control. In International Conference on Artificial General Intelligence (pp. 193-204). Springer, Cham.

[5] Holland, J. H. (1984). Genetic algorithms and adaptation. In Adaptive Control of Ill-Defined Systems (pp. 317-333). Springer, Boston, MA.

[6] Redmon, J., Divvala, S., Girshick, R., & Farhadi, A. (2016). You only look once: Unified, real-time object detection. In Proceedings of the IEEE conference on computer vision and pattern recognition (pp. 779-788).

[7] Wang, P. (2019). On Defining Artificial Intelligence. Journal of Artificial General Intelligence, 10(2), 1-37.

[8] Monett, D., Lewis, C. W., & Thórisson, K. R. (2020). Introduction to the JAGI Special Issue “On Defining Artificial Intelligence”—Commentaries and Author’s Response. Journal of Artificial General Intelligence, 11(2), 1-100.

【人工智能|通用人工智能的时代已经来临】[9] Wang, P. (2013). Non-axiomatic logic: A model of intelligent reasoning. World Scientific.

[10] Wang, P. (2009, October). Insufficient Knowledge and Resources-A Biological Constraint and Its Functional Implications. In AAAI Fall Symposium: Biologically Inspired Cognitive Architectures.

[11] Schrittwieser, J., Antonoglou, I., Hubert, T., Simonyan, K., Sifre, L., Schmitt, S., ... & Lillicrap, T. (2020). Mastering atari, go, chess and shogi by planning with a learned model. Nature, 588(7839), 604-609.

[12] Sutton, R. S., & Barto, A. G. (2018). Reinforcement learning: An introduction. MIT press.

[13] OpenNARS for Applications (ONA), last accessed January 3, 2021

推荐阅读

- 星链|石豪:在太空,马斯克和美国当局是如何作恶的

- 快报|“他,是能成就导师的学生”

- 区块|面向2030:影响数据存储产业的十大应用(下):新兴应用

- 年轻人|人生缺少的不是运气,而是少了这些高质量订阅号

- 生活|气笑了,这APP的年度报告是在嘲讽我吧

- bug|这款小工具让你的Win10用上“Win11亚克力半透明菜单”

- 苏宁|小门店里的暖心事,三位创业者的雪域坚守

- 历史|科普:詹姆斯·韦布空间望远镜——探索宇宙历史的“深空巨镜”

- 空间|(科技)科普:詹姆斯·韦布空间望远镜——探索宇宙历史的“深空巨镜”

- 生活|数字文旅的精彩生活